Lucene 4.4 以后近实时NRT检索

Lucene4.4之后,NRTManager 及NRTManagerReopenThread 已经都没有了,如果做近实时搜索的话,就要这么做,

初始化:

Directory directory = new RAMDirectory();

IndexWriterConfig iwc = new IndexWriterConfig(Version.LUCENE_48, new StandardAnalyzer(ver));

IndexWriter indexWriter = new IndexWriter(directory, iwc);

TrackingIndexWriter trackWriter = new TrackingIndexWriter(indexWriter);

searcherManager = new SearcherManager(indexWriter, true, new SearcherFactory());

ControlledRealTimeReopenThread<IndexSearcher> CRTReopenThread =

new ControlledRealTimeReopenThread<IndexSearcher>(trackWriter, searcherManager, 5.0, 0.025) ;

CRTReopenThread.setDaemon(true);

CRTReopenThread.setName("后台刷新服务");

CRTReopenThread.start();

添加文档:

trackWriter.addDocument(doc);

进行搜索:

IndexSearcher searcher = searcherManager.acquire();

......

searcherManager.release(searcher);

分布式搜索ElasticSearch构建集群与简单搜索实例应用 - 苏若年 - 博客园

分布式ElasticSearch集群构建的方法.

Code Samples - Zoie - Confluence

Zoie is a real-time search and indexing system built on Apache Lucene.

Donated by LinkedIn.com on July 19, 2008, and has been deployed in a real-time large-scale consumer website: LinkedIn.com handling millions of searches as well as millions of updates daily.

Configuration

Zoie can be configured via Spring:

Basic Search

This example shows how to set up basic indexing and search

thread 1: (indexing thread)

thread 2: (search thread)

Apache Solr vs ElasticSearch - the Feature Smackdown!

API

| Feature | Solr 4.7.0 | ElasticSearch 1.0 |

|---|---|---|

| Format | XML,CSV,JSON | JSON |

| HTTP REST API |  |

|

Binary API  |

SolrJ SolrJ |

TransportClient, Thrift (through a plugin) TransportClient, Thrift (through a plugin) |

| JMX support |  |

ES specific stats are exposed through the REST API ES specific stats are exposed through the REST API |

Client libraries  |

PHP, Ruby, Perl, Scala, Python, .NET, Javascript | PHP, Ruby, Perl, Scala, Python, .NET, Javascript, Erlang, Clojure |

3rd-party product integration (open-source) |

Drupal, Magento, Django, ColdFusion, Wordpress, OpenCMS, Plone, Typo3, ez Publish, Symfony2, Riak (via Yokozuna) | Drupal, Django, Symfony2, Wordpress, CouchBase |

3rd-party product integration (commercial) |

DataStax Enterprise Search, Cloudera Search, Hortonworks Data Platform, MapR | SearchBlox, Hortonworks Data Platform, MapR |

Output |

JSON, XML, PHP, Python, Ruby, CSV, Velocity, XSLT, native Java | JSON, XML/HTML (via plugin) |

Indexing

Searching

| Feature | Solr 4.7.0 | ElasticSearch 1.0 |

|---|---|---|

Lucene Query parsing  |

|

|

Structured Query DSL  |

Need to programmatically create queries if going beyond Lucene query syntax. Need to programmatically create queries if going beyond Lucene query syntax. |

|

Span queries  |

via SOLR-2703 via SOLR-2703 |

|

Spatial search  |

|

|

Multi-point spatial search  |

|

|

Faceting  |

|

The way top N facets work now is by getting the top N from each shard, and merging the results. This can giveincorrect counts when num shards > 1. The way top N facets work now is by getting the top N from each shard, and merging the results. This can giveincorrect counts when num shards > 1. |

Advanced Faceting  |

|

blog post blog post |

Pivot Facets  |

|

|

| More Like This |  |

|

Boosting by functions  |

|

|

Boosting using scripting languages  |

|

|

Push Queries  |

JIRA issue JIRA issue |

Percolation. Distributed percolation supported in 1.0 Percolation. Distributed percolation supported in 1.0 |

Field collapsing/Results grouping  |

|

possibly 1.0+ link possibly 1.0+ link |

| Spellcheck |  |

Suggest API Suggest API |

| Autocomplete |  |

Added in 0.90.3 here Added in 0.90.3 here |

Query elevation  |

|

workaround workaround |

Joins  |

It's not supported in distributed search. See LUCENE-3759. It's not supported in distributed search. See LUCENE-3759. |

via has_children and top_children queries via has_children and top_children queries |

Resultset Scrolling  |

New to 4.7.0 New to 4.7.0 |

via scan search type via scan search type |

Filter queries  |

|

also supports filtering by native scripts also supports filtering by native scripts |

Filter execution order  |

local params and cache property local params and cache property |

_cache and _cache_key property _cache and _cache_key property |

Alternative QueryParsers  |

DisMax, eDisMax DisMax, eDisMax |

query_string, dis_max, match, multi_match etc query_string, dis_max, match, multi_match etc |

Negative boosting  |

but awkward. Involves positively boosting the inverse set of negatively-boosted documents. but awkward. Involves positively boosting the inverse set of negatively-boosted documents. |

|

| Search across multiple indexes |  it can search across multiple compatible collections it can search across multiple compatible collections |

|

| Result highlighting |  |

|

Custom Similarity  |

|

|

Searcher warming on index reload  |

|

Warmers API Warmers API |

Customizability

Distributed

| Feature | Solr 4.7.0 | ElasticSearch 1.0 |

|---|---|---|

Self-contained cluster  |

Depends on separate ZooKeeper server Depends on separate ZooKeeper server |

Only ElasticSearch nodes Only ElasticSearch nodes |

| Automatic node discovery |  ZooKeeper ZooKeeper |

internal Zen Discovery or ZooKeeper internal Zen Discovery or ZooKeeper |

| Partition tolerance |  The partition without a ZooKeeper quorum will stop accepting indexing requests or cluster state changes, while the partition with a quorum continues to function. The partition without a ZooKeeper quorum will stop accepting indexing requests or cluster state changes, while the partition with a quorum continues to function. |

Partitioned clusters can diverge unless discovery.zen.minimum_master_nodes set to at least N/2+1, where N is the size of the cluster. If configured correctly, the partition without a quorum will stop operating, while the other continues to work. See this Partitioned clusters can diverge unless discovery.zen.minimum_master_nodes set to at least N/2+1, where N is the size of the cluster. If configured correctly, the partition without a quorum will stop operating, while the other continues to work. See this |

| Automatic failover |  If all nodes storing a shard and its replicas fail, client requests will fail, unless requests are made with the shards.tolerant=true parameter, in which case partial results are retuned from the available shards. If all nodes storing a shard and its replicas fail, client requests will fail, unless requests are made with the shards.tolerant=true parameter, in which case partial results are retuned from the available shards. |

|

| Automatic leader election |  |

|

| Shard replication |  |

|

Sharding  |

|

|

Automatic shard rebalancing |

|

it can be machine, rack, availability zone, and/or data center aware. Arbitrary tags can be assigned to nodes and it can be configured to not assign the same shard and its replicates on a node with the same tags. it can be machine, rack, availability zone, and/or data center aware. Arbitrary tags can be assigned to nodes and it can be configured to not assign the same shard and its replicates on a node with the same tags. |

| Change # of shards |  Shards can be added (when using implicit routing) or split (when using compositeId). Cannot be lowered. Replicas can be increased anytime. Shards can be added (when using implicit routing) or split (when using compositeId). Cannot be lowered. Replicas can be increased anytime. |

each index has 5 shards by default. Number of primary shards cannot be changed once the index is created. Replicas can be increased anytime. each index has 5 shards by default. Number of primary shards cannot be changed once the index is created. Replicas can be increased anytime. |

Relocate shards and replicas  |

can be done by creating a shard replicate on the desired node and then removing the shard from the source node can be done by creating a shard replicate on the desired node and then removing the shard from the source node |

can move shards and replicas to any node in the cluster on demand can move shards and replicas to any node in the cluster on demand |

Control shard routing  |

shards or _route_ parameter shards or _route_ parameter |

routing parameter routing parameter |

| Consistency | Indexing requests are synchronous with replication. A indexing request won't return until all replicas respond. No check for downed replicas. They will catch up when they recover. When new replicas are added, they won't start accepting and responding to requests until they are finished replicating the index. | Replication between nodes is synchronous by default, thus ES is consistent by default, but it can be set to asynchronous on a per document indexing basis. Index writes can be configured to fail is there are not sufficient active shard replicas. The default is quorum, but all or one are also available. |

Misc

| Feature | Solr 4.7.0 | ElasticSearch 1.0 |

|---|---|---|

| Web Admin interface |  bundled with Solr bundled with Solr |

via site plugins: elasticsearch-head, bigdesk, kopf,elasticsearch-HQ, Hammer via site plugins: elasticsearch-head, bigdesk, kopf,elasticsearch-HQ, Hammer |

| Hosting providers | WebSolr, Searchify, Hosted-Solr, IndexDepot, OpenSolr,gotosolr | bonsai.io, Indexisto, qbox.io, IndexDepot |

Thoughts...

As a number of folks point out in the discussion below, feature comparisons are inherently shallow and only go so far. I think they serve a purpose, but shouldn't be taken to be the last word on these 2 fantastic search products.

If you're running a smallish site and need search features without fancy bells-and-whistles, I think you'll be very happy with either Solr or ElasticSearch.

I've found ElasticSearch to be friendlier to teams which are used to REST APIs, JSON etc and don't have a Java background. If you're planning a large installation that requires running distributed search instances, I suspect you're also going to be happier with ElasticSearch.

As Matt Weber points out below, ElasticSearch was built to be distributed from the ground up, not tacked on as an 'afterthought' like it was with Solr. This is totally evident when examining the design and architecture of the 2 products, and also when browsing the source code.

Resources

- My other sites may be of interest if you're new to Lucene, Solr and ElasticSearch:

- The Solr wiki and the ElasticSearch Guide are your friends.

使用Lucene-Spatial实现集成地理位置的全文检索 - haiker - ITeye技术网站

Lucene通过Spatial包提供了对基于地理位置的全文检索的支持,最典型的应用场景就是:“搜索中关村附近1公里内的火锅店,并按远近排序”。使用Lucene-Spatial添加对地理位置的支持,和之前普通文本搜索主要有两点区别:

1. 将坐标信息转化为笛卡尔层,建立索引

- private void indexLocation(Document document, JSONObject jo)

- throws Exception {

- double longitude = jo.getDouble("longitude");

- double latitude = jo.getDouble("latitude");

- document.add(new Field("lat", NumericUtils

- .doubleToPrefixCoded(latitude), Field.Store.YES,

- Field.Index.NOT_ANALYZED));

- document.add(new Field("lng", NumericUtils

- .doubleToPrefixCoded(longitude), Field.Store.YES,

- Field.Index.NOT_ANALYZED));

- for (int tier = startTier; tier <= endTier; tier++) {

- ctp = new CartesianTierPlotter(tier, projector,

- CartesianTierPlotter.DEFALT_FIELD_PREFIX);

- final double boxId = ctp.getTierBoxId(latitude, longitude);

- document.add(new Field(ctp.getTierFieldName(), NumericUtils

- .doubleToPrefixCoded(boxId), Field.Store.YES,

- Field.Index.NOT_ANALYZED_NO_NORMS));

- }

- }

2. 搜索时,指定使用DistanceQueryFilter

- DistanceQueryBuilder dq = new DistanceQueryBuilder(latitude,

- longitude, miles, "lat", "lng",

- CartesianTierPlotter.DEFALT_FIELD_PREFIX, true, startTier,

- endTier);

- DistanceFieldComparatorSource dsort = new DistanceFieldComparatorSource(

- dq.getDistanceFilter());

- Sort sort = new Sort(new SortField("geo_distance", dsort));

下面是基于Lucene3.2.0和JUnit4.8.2的完整代码。

- <dependencies>

- <dependency>

- <groupId>junit</groupId>

- <artifactId>junit</artifactId>

- <version>4.8.2</version>

- <type>jar</type>

- <scope>test</scope>

- </dependency>

- <dependency>

- <groupId>org.apache.lucene</groupId>

- <artifactId>lucene-core</artifactId>

- <version>3.2.0</version>

- <type>jar</type>

- <scope>compile</scope>

- </dependency>

- <dependency>

- <groupId>org.apache.lucene</groupId>

- <artifactId>lucene-spatial</artifactId>

- <version>3.2.0</version>

- <type>jar</type>

- <scope>compile</scope>

- </dependency>

- <dependency>

- <groupId>org.json</groupId>

- <artifactId>json</artifactId>

- <version>20100903</version>

- <type>jar</type>

- <scope>compile</scope>

- </dependency>

- </dependencies>

首先准备测试用的数据:

- {"id":12,"title":"时尚码头美容美发热烫特价","longitude":116.3838183,"latitude":39.9629015}

- {"id":17,"title":"审美个人美容美发套餐","longitude":116.386564,"latitude":39.966102}

- {"id":23,"title":"海底捞吃300送300","longitude":116.38629,"latitude":39.9629573}

- {"id":26,"title":"仅98元!享原价335元李老爹","longitude":116.3846175,"latitude":39.9629125}

- {"id":29,"title":"都美造型烫染美发护理套餐","longitude":116.38629,"latitude":39.9629573}

- {"id":30,"title":"仅售55元!原价80元的老舍茶馆相声下午场","longitude":116.0799914,"latitude":39.9655391}

- {"id":33,"title":"仅售55元!原价80元的新笑声客栈早场","longitude":116.0799914,"latitude":39.9655391}

- {"id":34,"title":"仅售39元(红色礼盒)!原价80元的平谷桃","longitude":116.0799914,"latitude":39.9655391}

- {"id":46,"title":"仅售38元!原价180元地质礼堂白雪公主","longitude":116.0799914,"latitude":39.9655391}

- {"id":49,"title":"仅99元!享原价342.7元自助餐","longitude":116.0799914,"latitude":39.9655391}

- {"id":58,"title":"桑海教育暑期学生报名培训九折优惠券","longitude":116.0799914,"latitude":39.9655391}

- {"id":59,"title":"全国发货:仅29元!贝玲妃超模粉红高光光","longitude":116.0799914,"latitude":39.9655391}

- {"id":65,"title":"海之屿生态水族用品店抵用券","longitude":116.0799914,"latitude":39.9655391}

- {"id":67,"title":"小区东门时尚烫染个人护理美发套餐","longitude":116.3799914,"latitude":39.9655391}

- {"id":74,"title":"《郭德纲相声专辑》CD套装","longitude":116.0799914,"latitude":39.9655391}

根据上面的测试数据,编写测试用例,分别搜索坐标(116.3838183, 39.9629015)3千米以内的“美发”和全部内容,分别得到的结果应该是4条和6条。

- import static org.junit.Assert.assertEquals;

- import static org.junit.Assert.fail;

- import java.util.List;

- import org.junit.Test;

- public class LuceneSpatialTest {

- private static LuceneSpatial spatialSearcher = new LuceneSpatial();

- @Test

- public void testSearch() {

- try {

- long start = System.currentTimeMillis();

- List<String> results = spatialSearcher.search("美发", 116.3838183, 39.9629015, 3.0);

- System.out.println(results.size()

- + "个匹配结果,共耗时 "

- + (System.currentTimeMillis() - start) + "毫秒。\n");

- assertEquals(4, results.size());

- } catch (Exception e) {

- fail("Exception occurs...");

- e.printStackTrace();

- }

- }

- @Test

- public void testSearchWithoutKeyword() {

- try {

- long start = System.currentTimeMillis();

- List<String> results = spatialSearcher.search(null, 116.3838183, 39.9629015, 3.0);

- System.out.println( results.size()

- + "个匹配结果,共耗时 "

- + (System.currentTimeMillis() - start) + "毫秒.\n");

- assertEquals(6, results.size());

- } catch (Exception e) {

- fail("Exception occurs...");

- e.printStackTrace();

- }

- }

- }

下面是LuceneSpatial类,在构造函数中初始化变量和创建索引:

- public class LuceneSpatial {

- private Analyzer analyzer;

- private IndexWriter writer;

- private FSDirectory indexDirectory;

- private IndexSearcher indexSearcher;

- private IndexReader indexReader;

- private String indexPath = "c:/lucene-spatial";

- // Spatial

- private IProjector projector;

- private CartesianTierPlotter ctp;

- public static final double RATE_MILE_TO_KM = 1.609344; //英里和公里的比率

- public static final String LAT_FIELD = "lat";

- public static final String LON_FIELD = "lng";

- private static final double MAX_RANGE = 15.0; // 索引支持的最大范围,单位是千米

- private static final double MIN_RANGE = 3.0; // 索引支持的最小范围,单位是千米

- private int startTier;

- private int endTier;

- public LuceneSpatial() {

- try {

- init();

- } catch (Exception e) {

- e.printStackTrace();

- }

- }

- private void init() throws Exception {

- initializeSpatialOptions();

- analyzer = new StandardAnalyzer(Version.LUCENE_32);

- File path = new File(indexPath);

- boolean isNeedCreateIndex = false;

- if (path.exists() && !path.isDirectory())

- throw new Exception("Specified path is not a directory");

- if (!path.exists()) {

- path.mkdirs();

- isNeedCreateIndex = true;

- }

- indexDirectory = FSDirectory.open(new File(indexPath));

- //建立索引

- if (isNeedCreateIndex) {

- IndexWriterConfig indexWriterConfig = new IndexWriterConfig(

- Version.LUCENE_32, analyzer);

- indexWriterConfig.setOpenMode(OpenMode.CREATE_OR_APPEND);

- writer = new IndexWriter(indexDirectory, indexWriterConfig);

- buildIndex();

- }

- indexReader = IndexReader.open(indexDirectory, true);

- indexSearcher = new IndexSearcher(indexReader);

- }

- @SuppressWarnings("deprecation")

- private void initializeSpatialOptions() {

- projector = new SinusoidalProjector();

- ctp = new CartesianTierPlotter(0, projector,

- CartesianTierPlotter.DEFALT_FIELD_PREFIX);

- startTier = ctp.bestFit(MAX_RANGE / RATE_MILE_TO_KM);

- endTier = ctp.bestFit(MIN_RANGE / RATE_MILE_TO_KM);

- }

- private int mile2Meter(double miles) {

- double dMeter = miles * RATE_MILE_TO_KM * 1000;

- return (int) dMeter;

- }

- private double km2Mile(double km) {

- return km / RATE_MILE_TO_KM;

- }

创建索引的具体实现:

- private void buildIndex() {

- BufferedReader br = null;

- try {

- //逐行添加测试数据到索引中,测试数据文件和源文件在同一个目录下

- br = new BufferedReader(new InputStreamReader(

- LuceneSpatial.class.getResourceAsStream("data")));

- String line = null;

- while ((line = br.readLine()) != null) {

- index(new JSONObject(line));

- }

- writer.commit();

- } catch (Exception e) {

- e.printStackTrace();

- } finally {

- if (br != null) {

- try {

- br.close();

- } catch (IOException e) {

- e.printStackTrace();

- }

- }

- }

- }

- private void index(JSONObject jo) throws Exception {

- Document doc = new Document();

- doc.add(new Field("id", jo.getString("id"), Field.Store.YES,

- Field.Index.ANALYZED));

- doc.add(new Field("title", jo.getString("title"), Field.Store.YES,

- Field.Index.ANALYZED));

- //将位置信息添加到索引中

- indexLocation(doc, jo);

- writer.addDocument(doc);

- }

- private void indexLocation(Document document, JSONObject jo)

- throws Exception {

- double longitude = jo.getDouble("longitude");

- double latitude = jo.getDouble("latitude");

- document.add(new Field("lat", NumericUtils

- .doubleToPrefixCoded(latitude), Field.Store.YES,

- Field.Index.NOT_ANALYZED));

- document.add(new Field("lng", NumericUtils

- .doubleToPrefixCoded(longitude), Field.Store.YES,

- Field.Index.NOT_ANALYZED));

- for (int tier = startTier; tier <= endTier; tier++) {

- ctp = new CartesianTierPlotter(tier, projector,

- CartesianTierPlotter.DEFALT_FIELD_PREFIX);

- final double boxId = ctp.getTierBoxId(latitude, longitude);

- document.add(new Field(ctp.getTierFieldName(), NumericUtils

- .doubleToPrefixCoded(boxId), Field.Store.YES,

- Field.Index.NOT_ANALYZED_NO_NORMS));

- }

- }

搜索的具体实现:

- public List<String> search(String keyword, double longitude,

- double latitude, double range) throws Exception {

- List<String> result = new ArrayList<String>();

- double miles = km2Mile(range);

- DistanceQueryBuilder dq = new DistanceQueryBuilder(latitude,

- longitude, miles, "lat", "lng",

- CartesianTierPlotter.DEFALT_FIELD_PREFIX, true, startTier,

- endTier);

- //按照距离排序

- DistanceFieldComparatorSource dsort = new DistanceFieldComparatorSource(

- dq.getDistanceFilter());

- Sort sort = new Sort(new SortField("geo_distance", dsort));

- Query query = buildQuery(keyword);

- //搜索结果

- TopDocs hits = indexSearcher.search(query, dq.getFilter(),

- Integer.MAX_VALUE, sort);

- //获得各条结果相对应的距离

- Map<Integer, Double> distances = dq.getDistanceFilter()

- .getDistances();

- for (int i = 0; i < hits.totalHits; i++) {

- final int docID = hits.scoreDocs[i].doc;

- final Document doc = indexSearcher.doc(docID);

- final StringBuilder builder = new StringBuilder();

- builder.append("找到了: ")

- .append(doc.get("title"))

- .append(", 距离: ")

- .append(mile2Meter(distances.get(docID)))

- .append("米。");

- System.out.println(builder.toString());

- result.add(builder.toString());

- }

- return result;

- }

- private Query buildQuery(String keyword) throws Exception {

- //如果没有指定关键字,则返回范围内的所有结果

- if (keyword == null || keyword.isEmpty()) {

- return new MatchAllDocsQuery();

- }

- QueryParser parser = new QueryParser(Version.LUCENE_32, "title",

- analyzer);

- parser.setDefaultOperator(Operator.AND);

- return parser.parse(keyword.toString());

- }

执行测试用例,可以得到下面的结果:

- 找到了: 时尚码头美容美发热烫特价, 距离: 0米。

- 找到了: 都美造型烫染美发护理套餐, 距离: 210米。

- 找到了: 审美个人美容美发套餐, 距离: 426米。

- 找到了: 小区东门时尚烫染个人护理美发套餐, 距离: 439米。

- 4个匹配结果,共耗时 119毫秒。

- 找到了: 时尚码头美容美发热烫特价, 距离: 0米。

- 找到了: 仅98元!享原价335元李老爹, 距离: 68米。

- 找到了: 海底捞吃300送300, 距离: 210米。

- 找到了: 都美造型烫染美发护理套餐, 距离: 210米。

- 找到了: 审美个人美容美发套餐, 距离: 426米。

- 找到了: 小区东门时尚烫染个人护理美发套餐, 距离: 439米。

- 6个匹配结果,共耗时 3毫秒.

参考文献:

Lucene-Spatial的原理介绍:http://www.nsshutdown.com/projects/lucene/whitepaper/locallucene.htm

GeoHash:http://en.wikipedia.org/wiki/Geohash

两篇示例(其中大部分代码就来自于这里):

Lucene Spatial Example

使用 Apache Lucene 和 Solr 进行位置感知搜索

zookeeper+dubbo+dubbo管理集群的简要配置[单机] - goliathray的专栏 - 博客频道 - CSDN.NET

考虑到单机部署运行,在此文档中RegisterGroup 是单例的Zookeeper,部署集群模式的registerGroup请参考Zookeeper集群 http://wenku.baidu.com/view/641998d649649b6648d747a7.html

代码下载[不含 app的lib]http://download.csdn.net/detail/goliathray/5048969

需要的工具 eclipse tomcat

ProviderGroup:可以存在多个ProviderGroup,每个Group由多台Node组成,每个Node需要保证以下配置

1. 采用相同的application name

2. 保证provider的连接地址互不相同(在单机上部署多个provider需要保证端口不同)

3. 注册中心地址一致

ConsumerGroup:可以存在多个ConsumerGroup,每个Group由多台Node组成,每个Node需要保证能网络连接到所需业务的Provider并保证以下配置

1. 采用相同的application name

2. 注册中心地址一致

ProviderNode可以作为ConsumerNode调用别的ProviderGroup组的业务,相对的ConsumerNode也可以作为ProviderNode

RegisterGroup:注册中心组作为服务调用的分配者,每个RegisterNode监听除自身以外所有节点是否存活和健康(包括其RegisterGroup),本文档以Zookeeper单例部署为例子说明。

DubboAdmin:管理节点,可选节点,只作为一个管理者和观察者。

部署说明:

1. 在Eclipse中引入DubboConsumerNode1 - 3 和DubboProviderNode1 -3 共6个项目

2. 将DubboAdmin中的文件复制到apache-tomcat\webapps\ROOT下

3. Zookeeper已经做了基础配置,只需在 \zookeeper-3.4.4\bin启动 zkServer.cmd

Zoo.cfg配置说明

#tickTime:这个时间是作为 Zookeeper 服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每个 tickTime 毫秒时间就会发送一个心跳。

tickTime=2000

#dataDir:Zookeeper 保存数据的目录,默认情况下,Zookeeper 将写数据的日志文件也保存在这个目录里。

dataDir=/tmp/zookeeper

#dataLogDir:日志文件保存的位置(未配置)

dataLogDir=/tmp/zookeeper/log

#clientPort:这个端口就是客户端连接Zookeeper 服务器的端口,Zookeeper 会监听这个端口,接受客户端的访问请求。

clientPort=2181

#initLimit:这个配置项是用来配置 Zookeeper接受客户端(这里所说的客户端不是用户连接 Zookeeper 服务器的客户端,而是 Zookeeper 服务器集群中连接到 Leader 的 Follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。

#当已经超过 10 个心跳的时间(也就是tickTime)长度后 Zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是 10*2000=20 秒。

initLimit=10

启动顺序:

这个部署并不严格要求启动的前后顺序,建议启动顺序

1. 启动Zookeeper ,显示

2. 启动Tomcat,若先启动Tomcat则会一直监听Zookeeper服务是否启动,当Zookeeper启动后才会加载完成,启动完成后访问127.0.0.1:8080,以root/root 登陆,显示

3. 启动Provider,在eclipse中找到Provider1-3.java,直接运行main方法,每启动一个节点,显示

同时在提供者列表中会增加一个节点信息

3个Provider全启动后

4. 启动Consumer, 在eclipse中找到Consumer1-3.java,直接运行main方法,每启动一个节点,可以见到console有输出

在Provider的Console中有显示

同时在消费者列表有新增节点信息

3个Consumer全启动后

节点的异常:

ProviderNode异常:当某台ProviderNode宕机后,Register无法再获取此Provider的信息,但是在进行initLimit个心跳连接之前,Register会认为这个Node只是暂时出错,并不会把他剔除出Provider的列表,Consumer的调用会报错(在未配置容错的情况下),某台Consumer可能会显示

但是在经过initLimit次的心跳后,此节点会被剔除出Provider列表,访问恢复

ConsumerNode异常:除非存在P-C-P的循环,不会对此部署产生影响,在经过initLimit次的心跳后,在Consumer列表中被剔除

RegisterNode异常:参考Zookeeper集群异常

异常恢复:对于每个ProviderNode和ConsumerNode,只需要重启动后连接上Register,既可以恢复原有的服务状态。

DubboAdmin管理:

DubboAdmin本身的配置采用的是文件的方式保存配置信息,配置的结果信息会由各个节点保存到临时文件,以保证在重启服务后恢复到原有状态

权重负载均衡:默认采用的是随机权重的负载均衡,对于第一次加载的Provider服务,权重为100,服务的访问率为(节点服务权重/服务重权重)*100%,可以通过增减权重的方式改变节点的访问几率,在对1号节点增加4倍权重后,1号节点的访问概率变为66.7%,可以在3个Provider节点的Console中看到信息的增幅速度明显改变,1号节点的速度远大于其他2个节点。

自定义的负载均衡:可以新增负载均衡的规则,优先于默认的负载均衡,有随机,伦循,按最小并发3种规则,可以细化到方法。

消费者的容错:在Provider端出现异常时,可以默认返回一个容错值,默认为Null,可以自己配置,通过对Provider的Service设置mock类

启动容错后若Provider端出错,返回Null,优先于禁用

可以看到Consumer的Console报错

消费者的禁用:对于ConsumerNode,禁用后则不能访问任何Provider

若设置了容错,则返回NULL

若无容错,则返回调用异常

恢复后显示数据可以正常访问

提供者的禁用:禁止此Provider提供服务,(对下次启动生效),在重启动这个服务后显示

服务无法被访问,在点击启用后服务恢复

向oracle中导入导出 *.csv文件 - Eolande - 博客园

在 Oracle 数据库中,我们通常在不同数据库的表间记录进行复制或迁移时会用以下几种方法:

1. A 表的记录导出为一条条分号隔开的 insert 语句,然后执行插入到 B 表中

2. 建立数据库间的 dblink,然后用 create table B as select * from A@dblink where ...,或 insert into B select * from A@dblink where ...

3. exp A 表,再 imp 到 B 表,exp 时可加查询条件

4. 程序实现 select from A ..,然后 insert into B ...,也要分批提交

5. 再就是本篇要说到的 Sql Loader(sqlldr) 来导入数据,效果比起逐条 insert 来很明显

第 1 种方法在记录多时是个噩梦,需三五百条的分批提交,否则客户端会死掉,而且导入过程很慢。如果要不产生 REDO 来提高 insert into 的性能,就要下面那样做:

2

3 insert /* +APPEND */ into B(c1,c2) values(x,xx);

4 insert /* +APPEND */ into B select * from A@dblink where .....;

5

好啦,前面简述了 Oracle 中数据导入导出的各种方法,我想一定还有更高明的。下面重点讲讲 Oracle 的 Sql Loader (sqlldr) 的用法。

在命令行下执行 Oracle 的 sqlldr 命令,可以看到它的详细参数说明,要着重关注以下几个参数:

userid -- Oracle 的 username/password[@servicename]

control -- 控制文件,可能包含表的数据

-------------------------------------------------------------------------------------------------------

log -- 记录导入时的日志文件,默认为 控制文件(去除扩展名).log

bad -- 坏数据文件,默认为 控制文件(去除扩展名).bad

data -- 数据文件,一般在控制文件中指定。用参数控制文件中不指定数据文件更适于自动操作

errors -- 允许的错误记录数,可以用他来控制一条记录都不能错

rows -- 多少条记录提交一次,默认为 64

skip -- 跳过的行数,比如导出的数据文件前面几行是表头或其他描述

还有更多的 sqlldr 的参数说明请参考:sql loader的用法。

用例子来演示 sqlldr 的使用,有两种使用方法:

1. 只使用一个控制文件,在这个控制文件中包含数据

2. 使用一个控制文件(作为模板) 和一个数据文件

一般为了利于模板和数据的分离,以及程序的不同分工会使用第二种方式,所以先来看这种用法。数据文件可以是 CSV 文件或者以其他分割符分隔的,数据文件可以用 PL/SQL Developer 或者 Toad 导出,也可以用 SQL *Plus 的 spool 格式化产出,或是 UTL_FILE 包生成。另外,用 Toad 还能直接生成包含数据的控制文件。

首先,假定有这么一个表 users,并插入五条记录:

SQL*Loader: Release 9.2.0.1.0 - Production on 星期三 1月 7 22:26:25 2009 Copyright (c) 1982, 2002, Oracle Corporation. All rights reserved. 达到提交点,逻辑记录计数4 1) ROWS 的默认值为 64,你可以根据实际指定更合适的 ROWS 参数来指定每次提交记录数。(体验过在 PL/SQL Developer 中一次执行几条条以上的 insert 语句的情形吗?) 2)常规导入可以通过使用 INSERT语句来导入数据。Direct导入可以跳过数据库的相关逻辑(DIRECT=TRUE),而直接将数据导入到数据文件中,可以提高导入数据的性能。当然,在很多情况下,不能使用此参数(如果主键重复的话会使索引的状态变成UNUSABLE!)。 3) 通过指定 UNRECOVERABLE选项,可以关闭数据库的日志(是否要 alter table table1 nologging 呢?)。这个选项只能和 direct 一起使用。 4) 对于超大数据文件的导入就要用并发操作了,即同时运行多个导入任务. sqlldr userid=/ control=result1.ctl direct=true parallel=true 当加载大量数据时(大约超过10GB),最好抑制日志的产生: spool方法 导出数据时,如果用plsql导,数据的记录如果太大,速度慢的影响就会很明显,我们可以用spool方法。 spool常用的设置 以下是我的例子:第一步是写一个sql的文件,里面是spool的各种配置信息 $ cat test_spool.sql 第二步是写一个脚本,包括有连接的数据库信息等,例子如下: $ cat test_spool.sh 第三步是曾加test_spool.sh的执行权限,并执行test_spool.sh $ chmod +x test_spool.sh $./test_spool.sh 这里只介绍了spool的一种用法,另外还有其他的方法和设置,不过从网上的介绍来看,这个方法是比较好的,另外的方法的的主要区别是在sql语句的写法上,还增加了域分隔符的设置而已,出错概率高一些。 参考:Oracle spool 用法小结http://www.diybl.com/course/7_databases/oracle/oraclejs/2008918/143288.html http://fanzf24.blog.163.com/blog/static/33127648200912411428325/

insert into users values(2,NULL,5,to_date('2008-10-15','YYYY-MM-DD'));

insert into users values(3,'隔叶黄莺',8,to_date('2009-01-02','YYYY-MM-DD'));

insert into users values(4,'Kypfos',NULL,NULL);

insert into users values(5,'不知秋',1,to_date('2008-12-23','YYYY-MM-DD'));

1) 建立数据文件,我们这里用 PL/SQL Developer 导出表 users 的记录为 users_data.csv 文件,内容如下:

"1","1","Unmi","3","2009-1-5 20:34:44"

"2","2","","5","2008-10-15"

"3","3","隔叶黄莺","8","2009-1-2"

"4","4","Kypfos","",""

"5","5","不知秋","1","2008-12-23"

LOAD DATA

INFILE * -- 因为数据同控制文件在一起,所以用 * 表示

append -- 这里用了 append 来操作,在表 users 中附加记录

INTO TABLE users

when LOGIN_TIMES<>'8' -- 还可以用 when 子句选择导入符合条件的记录

Fields terminated by ","

trailing nullcols

(

virtual_column FILLER, --跳过由 PL/SQL Developer 生成的第一列序号

user_id "user_seq.nextval", --这一列直接取序列的下一值,而不用数据中提供的值

user_name "'Hi '||upper(:user_name)",--,还能用SQL函数或运算对数据进行加工处理

login_times terminated by ",", NULLIF(login_times='NULL') --可为列单独指定分隔符

last_login DATE "YYYY-MM-DD HH24:MI:SS" NULLIF (last_login="NULL") -- 当字段为"NULL"时就是 NULL

)

BEGINDATA --数据从这里开始

,USER_ID,USER_NAME,LOGIN_TIMES,LAST_LOGIN

1,1,Unmi,3,2009-1-5 20:34

2,2,Fantasia,5,2008-10-15

3,3,隔叶黄莺,8,2009-1-2

4,4,Kypfos,NULL,NULL

5,5,不知秋,1,2008-12-23

sqlldr dbuser/dbpass@dbservice control=users.ctl

比如,在控制台会显示这样的信息:

C:\>sqlldr dbuser/dbpass@dbservice control=users.ctl

达到提交点,逻辑记录计数5

上面的控制文件包含的内容比较复杂(演示目的),请根据注释理解每个参数的意义。还能由此发掘更多用法。

最后说下有关 SQL *Loader 的性能与并发操作

sqlldr userid=/ control=result2.ctl direct=true parallel=true

sqlldr userid=/ control=result2.ctl direct=true parallel=true

SQL>ALTER TABLE RESULTXT nologging;

这样不产生REDO LOG,可以提高效率。然后在 CONTROL 文件中 load data 上面加一行:unrecoverable, 此选项必须要与DIRECT共同应用。

在并发操作时,ORACLE声称可以达到每小时处理100GB数据的能力!其实,估计能到 1-10G 就算不错了,开始可用结构 相同的文件,但只有少量数据,成功后开始加载大量数据,这样可以避免时间的浪费。

参考:1. Oracle SQL*Loader -- 英文,Sql Loader 的官方使用说明,包含多种类型的 Demo

2. sql loader的用法 -- 列出了 sql loader 的选择参数的中文说明

3. 使用SQL Loader导入大量数据,避免使用SQL频繁写库 -- 一个简单的例子,快带了解 Sql Loader 的用法

4. Oracle SQL Loader的详细语法

5. oracle sql loader全攻略 -- 还算名符其实。并讲了如何用 SQL *Plus 的 spool 或 UTL_FILE 包生成数据文件

6. SQL*Loader Control File Reference -- 英文,控制文件使用参考

7. 学习oracle sql loader 的使用

8. 用sqlloader(sqlldr)装载LOB数据 -- LOB 的内类是一个外部文件,用 sql loader 导入到数据库

9. SQLLDR直接加载几个参数的测试

10.Maximizing SQL*Loader Performance

set colsep' '; //域输出分隔符

set echo off; //显示start启动的脚本中的每个sql命令,缺省为on

set feedback off; //回显本次sql命令处理的记录条数,缺省为on

set heading off; //输出域标题,缺省为on

set pagesize 0; //输出每页行数,缺省为24,为了避免分页,可设定为0。

set termout off; //显示脚本中的命令的执行结果,缺省为on

set trimout on; //去除标准输出每行的拖尾空格,缺省为off

set trimspool on; //去除重定向(spool)输出每行的拖尾空格,缺省为off

set feedback off

set heading off

set termout off

set pagesize 0

set linesize 150

set verify off

set echo off

spool /home/test/test_spool_out_file.sql --spool输出的文件

select field1||'|'||field2 from test_spool;

spool off

/home/oracle_app/bin/sqlplus test_user/test_pass << eof

@/home/test/test_spool.sql

exit;

eof

【log4jdbc】log4jdbc日志框架介绍_梁小坏Leo_新浪博客

配置方法

1.导入log4jdbcjar

JDK1.4 JDK1.5 选择 log4jdbc3-1.2.jar

JDK1.6 JDK1.7 选择 log4jdbc4-1.2.jar

2.导入SLF4J的jar

下载最新SLF4J

http://www.slf4j.org/download.html

下载之后将得到2个jar文件,导入项目classpath

3.修改你的项目的JDBC驱动

Driver Class

oracle.jdbc.driver.OracleDriver

oracle.jdbc.OracleDriver

com.sybase.jdbc2.jdbc.SybDriver

net.sourceforge.jtds.jdbc.Driver

com.microsoft.jdbc.sqlserver.SQLServerDriver

com.microsoft.sqlserver.jdbc.SQLServerDriver

weblogic.jdbc.sqlserver.SQLServerDriver

com.informix.jdbc.IfxDriver

org.apache.derby.jdbc.ClientDriver

org.apache.derby.jdbc.EmbeddedDriver

com.mysql.jdbc.Driver

org.postgresql.Driver

org.hsqldb.jdbcDriver

org.h2.Driver

4.修改JDBC连接URL

比如你的URL为

那么修改为

jdbc:log4jdbc:derby://localhost:1527//db-derby-10.2.2.0-bin/databases/MyDatabase

5.设置日志Logger在log4jdbc里面,新添加了5个Logger。

logger

jdbc.sqlonly

jdbc.sqltiming

jdbc.audit

jdbc.resultset

jdbc.connection

这里给出log4j.xml和log4j.properties的例子

log4j.xml

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE log4j:configuration SYSTEM "log4j.dtd">

<!-- An example log4j configuration xml file for log4jdbc -->

<!-- Logging levels are:

<!-- DEBUG < INFO < WARN < ERROR < FATAL

<log4j:configuration xmlns:log4j="http://jakarta.apache.org/log4j/">

</log4j:configuration>

log4j.properties

!==============================================================================

! log4j.properties - An example configuration properties file for log4j.

!

! Logging levels are:

! DEBUG < INFO < WARN < ERROR < FATAL

!==============================================================================

! turn on the internal log4j debugging flag so we can see what it is doing

log4j.debug=true

!==============================================================================

! JDBC API layer call logging :

! INFO shows logging, DEBUG also shows where in code the jdbc calls were made,

! setting DEBUG to true might cause minor slow-down in some environments.

! If you experience too much slowness, use INFO instead.

! Log all JDBC calls except for ResultSet calls

log4j.logger.jdbc.audit=INFO,jdbc

log4j.additivity.jdbc.audit=false

! Log only JDBC calls to ResultSet objects

log4j.logger.jdbc.resultset=INFO,jdbc

log4j.additivity.jdbc.resultset=false

! Log only the SQL that is executed.

log4j.logger.jdbc.sqlonly=DEBUG,sql

log4j.additivity.jdbc.sqlonly=false

! Log timing information about the SQL that is executed.

log4j.logger.jdbc.sqltiming=DEBUG,sqltiming

log4j.additivity.jdbc.sqltiming=false

! Log connection open/close events and connection number dump

log4j.logger.jdbc.connection=FATAL,connection

log4j.additivity.jdbc.connection=false

! the appender used for the JDBC API layer call logging above, sql only

log4j.appender.sql=org.apache.log4j.FileAppender

log4j.appender.sql.File=./logs/sql.log

log4j.appender.sql.Append=false

log4j.appender.sql.layout=org.apache.log4j.PatternLayout

log4j.appender.sql.layout.ConversionPattern=-----> %d{yyyy-MM-dd HH:mm:ss.SSS} %m%n%n

! the appender used for the JDBC API layer call logging above, sql timing

log4j.appender.sqltiming=org.apache.log4j.FileAppender

log4j.appender.sqltiming.File=./logs/sqltiming.log

log4j.appender.sqltiming.Append=false

log4j.appender.sqltiming.layout=org.apache.log4j.PatternLayout

log4j.appender.sqltiming.layout.ConversionPattern=-----> %d{yyyy-MM-dd HH:mm:ss.SSS} %m%n%n

! the appender used for the JDBC API layer call logging above

log4j.appender.jdbc=org.apache.log4j.FileAppender

log4j.appender.jdbc.File=./logs/jdbc.log

log4j.appender.jdbc.Append=false

log4j.appender.jdbc.layout=org.apache.log4j.PatternLayout

log4j.appender.jdbc.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss.SSS} %m%n

! the appender used for the JDBC Connection open and close events

log4j.appender.connection=org.apache.log4j.FileAppender

log4j.appender.connection.File=./logs/connection.log

log4j.appender.connection.Append=false

log4j.appender.connection.layout=org.apache.log4j.PatternLayout

log4j.appender.connection.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss.SSS} %m%n

6.更多细节以及设置,请参照主页

参照log4jdbc的文档,在log4jdbc.properties文件中配置参数。\

- log4jdbc.debug.stack.prefix,只显示含调用栈的包名的语句。

- log4jdbc.sqltiming.warn.threshold,执行时间阀值,单位为ms,将Log级别调为Warning,则只会打印执行较慢的语句。

- log4jdbc.dump.sql.select/insert/update/delete, 过滤掉某些类型的语句。

Gottox/socket.io-java-client · GitHub

Socket.IO-Client for Java

socket.io-java-client is an easy to use implementation of socket.io for Java.

It uses Weberknecht as transport backend, but it's easy to write your own transport. See description below. An XHR-Transport is included, too. But it's not functional in its current state.

The API is inspired by java-socket.io.client.

Features:

- transparent reconnecting - The API cares about re-establishing the connection to the server when the transport is interrupted.

- easy to use API - implement an interface, instantiate a class - you're done.

- output buffer - send data while the transport is still connecting. No problem, socket.io-java-client handles that.

- meaningful exceptions - If something goes wrong, SocketIO tries to throw meaningful exceptions with hints for fixing.

Status: Connecting with Websocket is production ready. XHR is in beta.

How to use

Using socket.io-java-client is quite simple. But lets see:

Checkout and compile the project:

git clone git://github.com/Gottox/socket.io-java-client.git

cd socket.io-java-client

ant jar

mv jar/socketio.jar /path/to/your/libs/project

If you're using ant, change your build.xml to include socketio.jar. If you're eclipse, add the jar to your project buildpath.

Afterwards, you'll be able to use this library:

SocketIO socket = new SocketIO("http://127.0.0.1:3001/");

socket.connect(new IOCallback() {

@Override

public void onMessage(JSONObject json, IOAcknowledge ack) {

try {

System.out.println("Server said:" + json.toString(2));

} catch (JSONException e) {

e.printStackTrace();

}

}

@Override

public void onMessage(String data, IOAcknowledge ack) {

System.out.println("Server said: " + data);

}

@Override

public void onError(SocketIOException socketIOException) {

System.out.println("an Error occured");

socketIOException.printStackTrace();

}

@Override

public void onDisconnect() {

System.out.println("Connection terminated.");

}

@Override

public void onConnect() {

System.out.println("Connection established");

}

@Override

public void on(String event, IOAcknowledge ack, Object... args) {

System.out.println("Server triggered event '" + event + "'");

}

});

// This line is cached until the connection is establisched.

socket.send("Hello Server!");

For further informations, read the Javadoc.

Checkout

-

with git

git clone git://github.com/Gottox/socket.io-java-client.git -

with mercurial

hg clone https://bitbucket.org/Gottox/socket.io-java-client

Both repositories are synchronized and up to date.

Building

to build a jar-file:

cd $PATH_TO_SOCKETIO_JAVA ant jar ls jar/socketio.jar You'll find the socket.io-jar in jar/socketio.jar

Bugs

Please report any bugs feature requests to the Github issue tracker

Frameworks

This Library was designed with portability in mind.

- Android is fully supported.

- JRE is fully supported.

- GWT does not work at the moment, but a port would be possible.

- Java ME does not work at the moment, but a port would be possible.

- ... is there anything else out there?

Testing

There comes a JUnit test suite with socket.io-java-client. Currently it's tested with Eclipse.

You need node installed in PATH.

- open the project with eclipse

- open tests/io.socket/AllTests.java

- run it as JUnit4 test.

netty-socketio使用namespace - 烟火_ - 博客园

一、简介

netty-socketio中的namespace可以用于区别在相同连接地址下的不同用户,当两个不同的用户打开同一个页面的时候,可以使用namespace用来标记不同用户。例如我们可以在用户中心页面动态的获取用户的消息数目。这里就可以使用到namespace。因为每个用户的id都是不一样的,我们可以使用id来标识每个用户的namespace。

二、示例

服务器端代码:

package com.test.socket;

import com.corundumstudio.socketio.Configuration;

import com.corundumstudio.socketio.SocketIONamespace;

import com.corundumstudio.socketio.SocketIOServer;

public class SocketServer2 {

public static void main(String[] args) throws InterruptedException {

Configuration config = new Configuration();

config.setHostname("localhost");

config.setPort(9092);

final SocketIOServer server = new SocketIOServer(config);

server.start();

String uid = "1111";

String namespace = String.format("/%s_%s", "msg", uid);//构建命名空间

SocketIONamespace chat1namespace = server.addNamespace(namespace); //设置命名空间

for (int i = 0; i < 50; i++) {

Thread.sleep(2000);

chat1namespace.getBroadcastOperations().sendEvent("message", 1); //每次发送数字一

}

Thread.sleep(Integer.MAX_VALUE);

server.stop();

}

}

客户端message.html代码:

1 <!DOCTYPE html PUBLIC "-//W3C//DTD HTML 4.01 Transitional//EN" "http://www.w3.org/TR/html4/loose.dtd"> 2 <html> 3 <head> 4 <meta http-equiv="Content-Type" content="text/html; charset=UTF-8"> 5 <title>Insert title here</title> 6 <script src="./jquery-1.9.1.js" type="text/javascript"></script> 7 <script type="text/javascript" src="./socket.io/socket.io.js"></script> 8 9 <style> 10 body { 11 padding:20px; 12 } 13 #console { 14 overflow: auto; 15 } 16 .username-msg {color:orange;} 17 .connect-msg {color:green;} 18 .disconnect-msg {color:red;} 19 .send-msg {color:#888} 20 </style> 21 22 </head> 23 24 <body> 25 26 <h1>Netty-socketio Demo Chat</h1> 27 28 <br/> 29 30 <div id="console" class="well"> 31 </div> 32 消息总数:<div id="msgnum">0</di> 33 </body> 34 35 36 37 <script type="text/javascript"> 38 var socket = io.connect('http://localhost:9092/msg_1111'); 39 40 socket.on('connect', function() { 41 output('<span class="connect-msg">Client has connected to the server!</span>'); 42 }); 43 44 socket.on('message', function(data) {//收到消息后,将消息总数加一 45 var num = $("#msgnum").html(); 46 num = parseInt(num) + data; 47 $("#msgnum").html(num); 48 }); 49 50 socket.on('disconnect', function() { 51 output('<span class="disconnect-msg">The client has disconnected!</span>'); 52 }); 53 function sendDisconnect() { 54 socket.disconnect(); 55 } 56 57 function output(message) { 58 var currentTime = "<span class='time'>" + new Date() + "</span>"; 59 var element = $("<div>" + currentTime + " " + message + "</div>"); 60 $('#console').prepend(element); 61 } 62 63 </script> 64 </html>

启动服务器,访问该网页,消息总数会每次加1。

#数据技术选型#即席查询Shib+Presto,集群任务调度HUE+Oozie - 旁观者 - 博客园

使用者是产品/运营/销售运营的数据分析师;要求数据分析师掌握查询SQL查询脚本编写技巧,掌握不同业务的数据存储在不同的数据集市里;不管他们的计算任务是提交给 数据库 还是 Hadoop,计算时间都可能会很长,不可能在线等待;所以,使用者提交了一个计算任务(PIG/SQL/Hive SQL),控制台告知任务已排队,给出大致的计算时间等友情提示, 这些作业的权重较低,使用者和管理员可以查看排队中的计算任务,包括已执行任务的执行时间、运行时长和运行结果;当计算任务有结果后,控制台界面有通知提示,或者发邮件提示,使用者可以在线查看和下载数据。

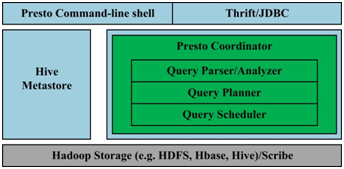

Presto 简化的架构如下图1所示,客户端将 SQL 查询发送到 Presto 的协调器。协调器会进行语法检查、分析和规划查询计划。调度器将执行的管道组合在一起,将任务分配给那些离数据最近的节点,然后监控执行过程。客户端从输出段中将数据取出,这些数据是从更底层的处理段中依次取出的。

Presto 的运行模型与 Hive 有着本质的区别。Hive 将查询翻译成多阶段的 Map-Reduce 任务,一个接着一个地运行。 每一个任务从磁盘上读取输入数据并且将中间结果输出到磁盘上。然而 Presto 引擎没有使用 Map-Reduce。它使用了一个定制的查询执行引擎和响应操作符来支持SQL的语法。除了改进的调度算法之外,所有的数据处理都是在内存中进行的。不同的处理端通过网络组成处理的流水线。这样会避免不必要的磁盘读写和额外的延迟。这种流水线式的执行模型会在同一时间运行多个数据处理段,一旦数据可用的时候就会将数据从一个处理段传入到下一个处理段。

这样的方式会大大的减少各种查询的端到端响应时间。

同时,Presto 设计了一个简单的数据存储抽象层,来满足在不同数据存储系统之上都可以使用 SQL 进行查询。存储连接器目前支持除 Hive/HDFS 外,还支持 HBase、Scribe 和定制开发的系统。

图1. Presto架构

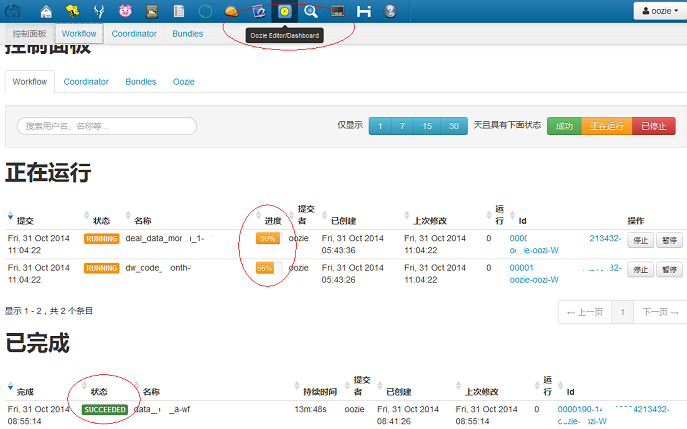

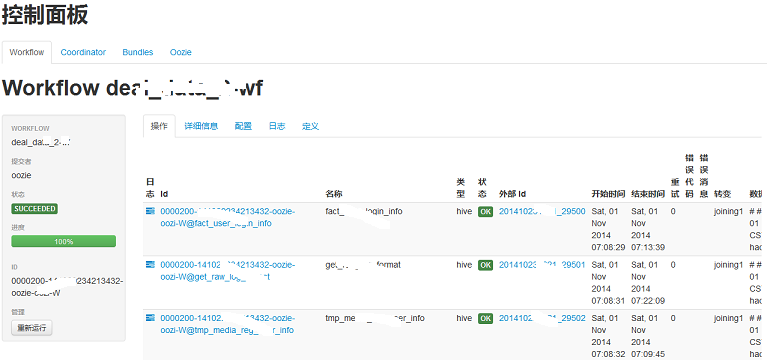

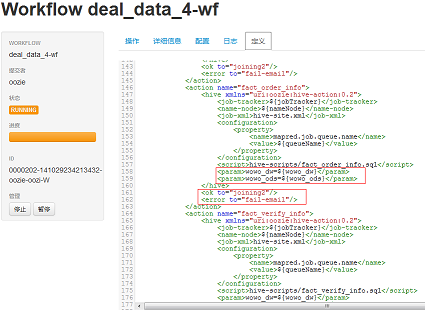

- Oozie允许失败的工作流从任意点重新运行,这对于处理工作流中由于前一个耗时活动而出现瞬态错误的情况非常有用。

- 工作流执行过程可视化。

- 工作流的每一步的日志、错误信息都可以点击查看,并实时滚动,便于排查问题。

Nginx优化教程 实现突破十万并发_源码_站长之家ChinaZ.com

nginx指令中的优化(配置文件)

worker_processes 8;

nginx进程数,建议按照cpu数目来指定,一般为它的倍数。

worker_cpu_affinity 00000001 00000010 00000100 00001000 00010000 00100000 01000000 10000000;

为每个进程分配cpu,上例中将8个进程分配到8个cpu,当然可以写多个,或者将一个进程分配到多个cpu。

worker_rlimit_nofile 102400;

这个指令是指当一个nginx进程打开的最多文件描述符数目,理论值应该是最多打开文件数(ulimit -n)与nginx进程数相除,但是nginx分配请求并不是那么均匀,所以最好与ulimit -n的值保持一致。

use epoll;

使用epoll的I/O模型,这个不用说了吧。

worker_connections 102400;

每个进程允许的最多连接数,理论上每台nginx服务器的最大连接数为worker_processes*worker_connections。

keepalive_timeout 60;

keepalive超时时间。

client_header_buffer_size 4k;

客户端请求头部的缓冲区大小,这个可以根据你的系统分页大小来设置,一般一个请求的头部大小不会超过1k,不过由于一般系统分页都要大于1k,所以这里设置为分页大小。分页大小可以用命令getconf PAGESIZE取得。

open_file_cache max=102400 inactive=20s;

这个将为打开文件指定缓存,默认是没有启用的,max指定缓存数量,建议和打开文件数一致,inactive是指经过多长时间文件没被请求后删除缓存。

open_file_cache_valid 30s;

这个是指多长时间检查一次缓存的有效信息。

open_file_cache_min_uses 1;

open_file_cache指令中的inactive参数时间内文件的最少使用次数,如果超过这个数字,文件描述符一直是在缓存中打开的,如上例,如果有一个文件在inactive时间内一次没被使用,它将被移除。

内核参数的优化

net.ipv4.tcp_max_tw_buckets = 6000

timewait的数量,默认是180000。

net.ipv4.ip_local_port_range = 1024 65000

允许系统打开的端口范围。

net.ipv4.tcp_tw_recycle = 1

启用timewait快速回收。

net.ipv4.tcp_tw_reuse = 1

开启重用。允许将TIME-WAIT sockets重新用于新的TCP连接。

net.ipv4.tcp_syncookies = 1

开启SYN Cookies,当出现SYN等待队列溢出时,启用cookies来处理。

net.core.somaxconn = 262144

web应用中listen函数的backlog默认会给我们内核参数的net.core.somaxconn限制到128,而nginx定义的NGX_LISTEN_BACKLOG默认为511,所以有必要调整这个值。

net.core.netdev_max_backlog = 262144

每个网络接口接收数据包的速率比内核处理这些包的速率快时,允许送到队列的数据包的最大数目。

net.ipv4.tcp_max_orphans = 262144

系统中最多有多少个TCP套接字不被关联到任何一个用户文件句柄上。如果超过这个数字,孤儿连接将即刻被复位并打印出警告信息。这个限制仅仅是为了防止简单的DoS攻击,不能过分依靠它或者人为地减小这个值,更应该增加这个值(如果增加了内存之后)。

net.ipv4.tcp_max_syn_backlog = 262144

记录的那些尚未收到客户端确认信息的连接请求的最大值。对于有128M内存的系统而言,缺省值是1024,小内存的系统则是128。

net.ipv4.tcp_timestamps = 0

时间戳可以避免序列号的卷绕。一个1Gbps的链路肯定会遇到以前用过的序列号。时间戳能够让内核接受这种"异常"的数据包。这里需要将其关掉。

net.ipv4.tcp_synack_retries = 1

为了打开对端的连接,内核需要发送一个SYN并附带一个回应前面一个SYN的ACK。也就是所谓三次握手中的第二次握手。这个设置决定了内核放弃连接之前发送SYN+ACK包的数量。

net.ipv4.tcp_syn_retries = 1

在内核放弃建立连接之前发送SYN包的数量。

net.ipv4.tcp_fin_timeout = 1

如果套接字由本端要求关闭,这个参数决定了它保持在FIN-WAIT-2状态的时间。对端可以出错并永远不关闭连接,甚至意外当机。缺省值是60秒。2.2 内核的通常值是180秒,你可以按这个设置,但要记住的是,即使你的机器是一个轻载的WEB服务器,也有因为大量的死套接字而内存溢出的风险,FIN- WAIT-2的危险性比FIN-WAIT-1要小,因为它最多只能吃掉1.5K内存,但是它们的生存期长些。

net.ipv4.tcp_keepalive_time = 30

当keepalive起用的时候,TCP发送keepalive消息的频度。缺省是2小时。

一个完整的内核优化配置

net.ipv4.ip_forward = 0

net.ipv4.conf.default.rp_filter = 1

net.ipv4.conf.default.accept_source_route = 0

kernel.sysrq = 0

kernel.core_uses_pid = 1

net.ipv4.tcp_syncookies = 1

kernel.msgmnb = 65536

kernel.msgmax = 65536

kernel.shmmax = 68719476736

kernel.shmall = 4294967296

net.ipv4.tcp_max_tw_buckets = 6000

net.ipv4.tcp_sack = 1

net.ipv4.tcp_window_scaling = 1

net.ipv4.tcp_rmem = 4096 87380 4194304

net.ipv4.tcp_wmem = 4096 16384 4194304

net.core.wmem_default = 8388608

net.core.rmem_default = 8388608

net.core.rmem_max = 16777216

net.core.wmem_max = 16777216

net.core.netdev_max_backlog = 262144

net.core.somaxconn = 262144

net.ipv4.tcp_max_orphans = 3276800

net.ipv4.tcp_max_syn_backlog = 262144

net.ipv4.tcp_timestamps = 0

net.ipv4.tcp_synack_retries = 1

net.ipv4.tcp_syn_retries = 1

net.ipv4.tcp_tw_recycle = 1

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_mem = 94500000 915000000 927000000

net.ipv4.tcp_fin_timeout = 1

net.ipv4.tcp_keepalive_time = 30

net.ipv4.ip_local_port_range = 1024 65000

一个简单的nginx优化配置文件

user www www;

worker_processes 8;

worker_cpu_affinity 00000001 00000010 00000100 00001000 00010000 00100000 01000000;

error_log /www/log/nginx_error.log crit;

pid /usr/local/nginx/nginx.pid;

worker_rlimit_nofile 204800;

events

{

use epoll;

worker_connections 204800;

}

http

{

include mime.types;

default_type application/octet-stream;

charset utf-8;

server_names_hash_bucket_size 128;

client_header_buffer_size 2k;

large_client_header_buffers 4 4k;

client_max_body_size 8m;

sendfile on;

tcp_nopush on;

keepalive_timeout 60;

fastcgi_cache_path /usr/local/nginx/fastcgi_cache levels=1:2

keys_zone=TEST:10m

inactive=5m;

fastcgi_connect_timeout 300;

fastcgi_send_timeout 300;

fastcgi_read_timeout 300;

fastcgi_buffer_size 16k;

fastcgi_buffers 16 16k;

fastcgi_busy_buffers_size 16k;

fastcgi_temp_file_write_size 16k;

fastcgi_cache TEST;

fastcgi_cache_valid 200 302 1h;

fastcgi_cache_valid 301 1d;

fastcgi_cache_valid any 1m;

fastcgi_cache_min_uses 1;

fastcgi_cache_use_stale error timeout invalid_header http_500;

open_file_cache max=204800 inactive=20s;

open_file_cache_min_uses 1;

open_file_cache_valid 30s;

tcp_nodelay on;

gzip on;

gzip_min_length 1k;

gzip_buffers 4 16k;

gzip_http_version 1.0;

gzip_comp_level 2;

gzip_types text/plain application/x-javascript text/css application/xml;

gzip_vary on;

server

{

listen 8080;

server_name ad.test.com;

index index.php index.htm;

root /www/html/;

location /status

{

stub_status on;

}

location ~ .*\.(php|php5)?$

{

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

include fcgi.conf;

}

location ~ .*\.(gif|jpg|jpeg|png|bmp|swf|js|css)$

{

expires 30d;

}

log_format access '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" $http_x_forwarded_for';

access_log /www/log/access.log access;

}

}

关于FastCGI的几个指令

fastcgi_cache_path /usr/local/nginx/fastcgi_cache levels=1:2 keys_zone=TEST:10m inactive=5m;

这个指令为FastCGI缓存指定一个路径,目录结构等级,关键字区域存储时间和非活动删除时间。

fastcgi_connect_timeout 300;

指定连接到后端FastCGI的超时时间。

fastcgi_send_timeout 300;

向FastCGI传送请求的超时时间,这个值是指已经完成两次握手后向FastCGI传送请求的超时时间。

fastcgi_read_timeout 300;

接收FastCGI应答的超时时间,这个值是指已经完成两次握手后接收FastCGI应答的超时时间。

fastcgi_buffer_size 16k;

指定读取FastCGI应答第一部分需要用多大的缓冲区,这里可以设置为fastcgi_buffers指令指定的缓冲区大小,上面的指令指定它将使用1个16k的缓冲区去读取应答的第一部分,即应答头,其实这个应答头一般情况下都很小(不会超过1k),但是你如果在fastcgi_buffers指令中指定了缓冲区的大小,那么它也会分配一个fastcgi_buffers指定的缓冲区大小去缓存。

fastcgi_buffers 16 16k;

指定本地需要用多少和多大的缓冲区来缓冲FastCGI的应答,如上所示,如果一个php脚本所产生的页面大小为256k,则会为其分配16个16k的缓冲区来缓存,如果大于256k,增大于256k的部分会缓存到fastcgi_temp指定的路径中,当然这对服务器负载来说是不明智的方案,因为内存中处理数据速度要快于硬盘,通常这个值的设置应该选择一个你的站点中的php脚本所产生的页面大小的中间值,比如你的站点大部分脚本所产生的页面大小为256k就可以把这个值设置为16 16k,或者4 64k 或者64 4k,但很显然,后两种并不是好的设置方法,因为如果产生的页面只有32k,如果用4 64k它会分配1个64k的缓冲区去缓存,而如果使用64 4k它会分配8个4k的缓冲区去缓存,而如果使用16 16k则它会分配2个16k去缓存页面,这样看起来似乎更加合理。

fastcgi_busy_buffers_size 32k;

这个指令我也不知道是做什么用,只知道默认值是fastcgi_buffers的两倍。

fastcgi_temp_file_write_size 32k;

在写入fastcgi_temp_path时将用多大的数据块,默认值是fastcgi_buffers的两倍。

fastcgi_cache TEST

开启FastCGI缓存并且为其制定一个名称。个人感觉开启缓存非常有用,可以有效降低CPU负载,并且防止502错误。但是这个缓存会引起很多问题,因为它缓存的是动态页面。具体使用还需根据自己的需求。

fastcgi_cache_valid 200 302 1h;

fastcgi_cache_valid 301 1d;

fastcgi_cache_valid any 1m;

为指定的应答代码指定缓存时间,如上例中将200,302应答缓存一小时,301应答缓存1天,其他为1分钟。

fastcgi_cache_min_uses 1;

缓存在fastcgi_cache_path指令inactive参数值时间内的最少使用次数,如上例,如果在5分钟内某文件1次也没有被使用,那么这个文件将被移除。

fastcgi_cache_use_stale error timeout invalid_header http_500;

不知道这个参数的作用,猜想应该是让nginx知道哪些类型的缓存是没用的。 以上为nginx中FastCGI相关参数,另外,FastCGI自身也有一些配置需要进行优化,如果你使用php-fpm来管理FastCGI,可以修改配置文件中的以下值:

<value name="max_children">60</value>

同时处理的并发请求数,即它将开启最多60个子线程来处理并发连接。

<value name="rlimit_files">102400</value>

最多打开文件数。

<value name="max_requests">204800</value>

每个进程在重置之前能够执行的最多请求数。

Anychart图表系列五之事件监听 - 上善若水任方圆 - ITeye技术网站

创建图表事件监听非常简单:首先是通过addEventListener('监听类型',js监听方法)添加事件监听,然后在js监听方法中定义具体监听逻辑。

以钻取操作为例,当用户点击图表某一个point的时候弹出point的name和value,代码如下:

- <script>

- //创建AnyChart

- var chart = new AnyChart();

- //添加钻取操作"pointClick"事件监听

- chart.addEventListener('pointClick', onPointClick);

- //钻取操作事件Event Handler

- function onPointClick(e) {

- // 读取point name

- var name=e.data.Name;

- // 读取point value

- var value=e.data.YValue;

- // 读取自定义属性point attribute

- var attribute = e.data.Attributes['test'];

- //弹出提示框

- alert("point_name="+name+" point_value="+value);

- }

- </script>

我们项目有一个需求是:点击图表某一个point的时候可以穿透打开一个新页面,这个新页面其实就是统计数据的详细列表,那么要做这样的功能就必须在图表中传入一个URL,图表在穿透时获取这个URL并打开详细列表页面。最后我是这样实现这个功能的:给每个point定义id属性,而这个id就是URL,然后在js中创建钻取事件监听,钻取时取id值再进行跳转。

- <!--AnyChart配置-->

- <point id="http://xxx/xxx.do?method=xx?id=xx" name="" value="">

- <script>

- //创建AnyChart

- var chart = new AnyChart();

- //添加钻取操作"pointClick"事件监听

- chart.addEventListener('pointClick', onPointClick);

- //钻取操作事件Event Handler

- function onPointClick(e) {

- //读取point id

- var url=e.data.id;

- //创建弹出框并访问指定地址

- openDialog(url);

- }

- </script>

当然有一点细节需要注意:如果id是通过后台代码拼装的,最好进行一次字符转换,否则很可能会出现XML解析错误,以java代码为例:

- String url = "http://xxxx";

- url = StringEscapeUtils.escapeHtml(url);

AnyChart支持图表“钻取”功能,除此之外还提供了鼠标移入、移出、图表创建、渲染中、渲染结束等等事件的监听,开发可以根据不同事件点去做一些特殊操作。

一个图可以监听多个不同的事件,要想监听多个,则只需要执行多次addEventListener即可。

- function init() {

- // Create new chart

- var chart = new AnyChart();

- // Add event handlers for all point events

- chart.addEventListener('pointClick', onPointClick);

- chart.addEventListener('pointSelect', onPointSelect);

- chart.addEventListener('pointMouseOver', onPointMouseOver);

- chart.addEventListener('pointMouseOut', onPointMouseOut);

- // Set data XML File

- chart.setXMLFile('./data.xml');

- //Output chart to "chartContainer" div

- chart.write('chartContainer');

- }

更多的事件监听在这就不做赘述,大家可以访问AnyChart帮助文档学习,里面说得非常详细

使用HBase EndPoint(coprocessor)进行计算 « 搜索技术博客-淘宝

如果要统对hbase中的数据,进行某种统计,比如统计某个字段最大值,统计满足某种条件的记录数,统计各种记录特点,并按照记录特点分类(类似于sql的group by)~

常规的做法就是把hbase中整个表的数据scan出来,或者稍微环保一点,加一个filter,进行一些初步的过滤(对于rowcounter来说,就加了FirstKeyOnlyFilter),但是这么做来说还是会有很大的副作用,比如占用大量的网络带宽(当标级别到达千万级别,亿级别之后)尤为明显,RPC的量也是不容小觑的。

理想的方式应该是怎样?

拿row counter这个简单例子来说,我要统计总行数,如果每个region 告诉我他又多少行,然后把结果告诉我,我再将他们的结果汇总一下,不就行了么?

现在的问题是hbase没有提供这种接口,来统计每个region的行数,那是否我们可以自己来实现一个呢?

没错,正如本文标题所说,我们可以自己来实现一个Endpoint,然后让hbase加载起来,然后我们远程调用即可。

什么是Endpoint?

先弄清楚什么是hbase coprocessor

hbase有两种coprocessor,一种是Observer(观察者),类似于关系数据库的trigger(触发器),另外一种就是EndPoint,类似于关系数据库的存储过程。

观察者这里就多做介绍了,这里介绍Endpoint。

EndPoint是动态RPC插件的接口,它的实现代码被部署在服务器端(regionServer),从而能够通过HBase RPC调用。客户端类库提供了非常方便的方法来调用这些动态接口,它们可以在任意时候调用一个EndPoint,它们的实现代码会被目标region远程执行,结果会返回到终端。用户可以结合使用这些强大的插件接口,为HBase添加全新的特性。

怎么实现一个EndPoint

1. 定义一个新的protocol接口,必须继承CoprocessorProtocol.

2. 实现终端接口,继承抽象类BaseEndpointCoprocessor,改实现代码需要部署到

3. 在客户端,终端可以被两个新的HBase Client API调用 。单个region:HTableInterface.coprocessorProxy(Class<T> protocol, byte[] row) 。rigons区域:HTableInterface.coprocessorExec(Class<T> protocol, byte[] startKey, byte[] endKey, Batch.Call<T,R> callable),这里的region是通过一个row来标示的,就是说,改row落到那个region,RPC就发给哪个region,对于start-end的,[start,end)范围内的region都会受到RPC调用。

|

1

2

3

|

public interface CounterProtocol extends CoprocessorProtocol { public long count(byte[] start, byte[] end) throws IOException;} |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

public class CounterEndPoint extends BaseEndpointCoprocessor implements CounterProtocol { @Override public long count(byte[] start, byte []end) throws IOException { // aggregate at each region Scan scan = new Scan(); long numRow = 0; InternalScanner scanner = ((RegionCoprocessorEnvironment) getEnvironment()).getRegion() .getScanner(scan); try { List<KeyValue> curVals = new ArrayList<KeyValue>(); boolean hasMore = false; do { curVals.clear(); hasMore = scanner.next(curVals); if (Bytes.compareTo(curVals.get(0).getRow(), start)<0) { continue; } if (Bytes.compareTo(curVals.get(0).getRow(), end)>= 0) { break; } numRow++; } while (hasMore); } finally { scanner.close(); } return numRow; }} |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

|

public class CounterEndPointDemo { public static void main(String[] args) throws IOException, Throwable { final String startRow = args[0]; final String endRow = args[1]; @SuppressWarnings("resource") HTableInterface table = new HTable(HBaseConfiguration.create(), "tc"); Map<byte[], Long> results; // scan: for all regions results = table.coprocessorExec(CounterProtocol.class, startRow.getBytes(), endRow.getBytes(), new Batch.Call<CounterProtocol, Long>() { public Long call(CounterProtocol instance) throws IOException { return instance.count(startRow.getBytes(), endRow.getBytes()); } }); long total = 0; for (Map.Entry<byte[], Long> e : results.entrySet()) { System.out.println(e.getValue()); total += e.getValue(); } System.out.println("total:" + total); }} |

整个程序的框架其实又是另外一个mapreduce,只是运行在region server上面,reduce运行在客户端,其中map计算量较大,reduce计算量很小!

另外需要提醒的是:

protocol的返回类型,可以是基本类型。

如果是一个自定义的类型需要实现org.apache.hadoop.io.Writable接口。

关于详细的支持类型,请参考代码hbase源码:org.apache.hadoop.hbase.io.HbaseObjectWritable

怎么部署?

1. 通过hbase-site.xml增加

|

1

2

3

4

|

<property> <name>hbase.coprocessor.region.classes</name> <value>xxxx.CounterEndPoint </value></property> |

- 如果要配置多个,就用逗号(,)分割。

- 包含此类的jar必须位于hbase的classpath

- 这种coprocessor是作用于所有的表,如果你只想作用于部分表,请使用下面一种方式。

2. 通过shell方式

增加:

|

1

2

3

4

5

6

|

hbase(main):005:0> alter 't1', METHOD => 'table_att',Updating all regions with the new schema...1/1 regions updated.Done.0 row(s) in 1.0730 seconds |

coprocessor格式为:

[FilePath]|ClassName|Priority|arguments

arguments: k=v[,k=v]+

- 其中FilePath是hdfs路径,例如/tmp/zhenhe/cp/zhenhe-1.0.jar

- ClassNameEndPoint实现类的全名

- Priority为,整数,框架会根据这个数据决定多个cp的执行顺序

- Arguments,传给cp的参数

- 如果hbase的classpath包含改类,FilePath可以留空

卸载:

- 先describe “tableName‘,查看你要卸载的cp的编号

- 然后alter 't1', METHOD => 'table_att_unset', NAME=> 'coprocessor$3',coprocessor$3可变。

应用场景

这是一个最简单的例子,另外还有很多统计场景,可以用在这种方式实现,有如下好处:

- 节省网络带宽

- 减少RPC调用(scan的调用随着CacheSzie的变小而线性增加),减轻hbase压力

- 可以提高统计效率,那我之前写过的一个groupby类型的例子来说,大约可以提高50%以上的统计速度。

其他应用场景?

- 一个保存着用户信息的表,可以统计每个用户信息(counter job)

- 统计最大值,最小值,平均值,参考:https://issues.apache.org/jira/browse/HBASE-1512

- 批量删除记录,批量删除某个时间戳的记录

参考:

1. http://blogs.apache.org/hbase/entry/coprocessor_introduction

2. https://issues.apache.org/jira/browse/HBASE-1512

hbase用coprocessor实现二级索引 | 邓的博客

HBase在0.92之后引入了coprocessors,提供了一系列的钩子,让我们能够轻易实现访问控制和二级索引的特性。下面简单介绍下两种coprocessors,第一种是Observers,它实际类似于触发器,第二种是Endpoint,它类似与存储过程。由于这里只用到了Observers,所以只介绍Observers,想要更详细的介绍请查阅(https://blogs.apache.org/hbase/entry/coprocessor_introduction)。observers分为三种:

RegionObserver:提供数据操作事件钩子;

WALObserver:提供WAL(write ahead log)相关操作事件钩子;

MasterObserver:提供DDL操作事件钩子。

相关接口请参阅hbase api。

下面给出一个例子,该例子使用RegionObserver实现在写主表之前将索引数据先写到另外一个表:

1 |

package com.dengchuanhua.testhbase; |

2 |

3 |

import java.io.IOException; |

4 |

import java.util.Iterator; |

5 |

import java.util.List; |

6 |

7 |

import org.apache.hadoop.conf.Configuration; |

8 |

import org.apache.hadoop.hbase.KeyValue; |

9 |

import org.apache.hadoop.hbase.client.HTable; |

10 |

import org.apache.hadoop.hbase.client.Put; |

11 |

import org.apache.hadoop.hbase.coprocessor.BaseRegionObserver; |

12 |

import org.apache.hadoop.hbase.coprocessor.ObserverContext; |

13 |

import org.apache.hadoop.hbase.coprocessor.RegionCoprocessorEnvironment; |

14 |

import org.apache.hadoop.hbase.regionserver.wal.WALEdit; |

15 |

16 |

public class TestCoprocessor extends BaseRegionObserver { |

17 |

18 |

@Override |

19 |

public void prePut(final ObserverContext<RegionCoprocessorEnvironment> e, |

20 |

final Put put, final WALEdit edit, final boolean writeToWAL) |

21 |

throws IOException { |

22 |

//set configuration |

23 |

Configuration conf = new Configuration(); |

24 |

//need conf.set... |

25 |

26 |

HTable table = new HTable(conf, "indexTableName"); |

27 |

List<KeyValue> kv = put.get("familyName".getBytes(), "columnName".getBytes()); |

28 |

Iterator<KeyValue> kvItor = kv.iterator(); |

29 |

while (kvItor.hasNext()) { |

30 |

KeyValue tmp = kvItor.next(); |

31 |

Put indexPut = new Put(tmp.getValue()); |

32 |

indexPut.add("familyName".getBytes(), "columnName".getBytes(), tmp.getRow()); |

33 |

table.put(indexPut); |

34 |

} |

35 |

table.close(); |

36 |

} |

37 |

38 |

} |

写完后要加载到table里面去,先把该文件打包成test.jar并上传到hdfs的/demo路径下,然后操作如下:

1. disable ‘testTable’

2. alter ‘testTable’, METHOD=>’table_att’,’coprocessor’=>’hdfs:///demo/test.jar|com.dengchuanhua.testhbase.TestCoprocessor|1001′

3. enable ‘testTable’

然后往testTable里面插数据就会自动往indexTableName写数据了。

总结:本文主要介绍了一个用coprocessor实现二级索引的例子。

[HBase] Hbase Coprocessors - 芒果先生Mango的专栏 - 博客频道 - CSDN.NET

本文是笔者学习过程中的简单笔记,日后会逐渐增加内容,主要参考资料是《Hbase The Definitive Guide》。

我们可以通过Filter来减少从Server到Client在网络上传输的数据总量,以提升效率。通过HBase的Coprocessor特性,我们甚至可以将计算(computation)移动到数据所在的节点。

Introduction to Coprocessors

coprocessor使你能够直接在每个region server上执行任意的代码。更精确地说,它提供一些通过事件触发的功能,以region为基础执行code;这很像关系型数据库系统中的procedures(存储过程)。

在使用coprocessor时,你需要基于特定的interface创建专门的类,以jar包的形式提供给region server (如:可以将jar包放到$HBASE_HOME/lib/目录下)。这些coprocessor类可以通过配置文件静态加载,也可以在程序代码中动态加载。

corpocessor 框架提供了两种coprocessor基类:

1.Observer

这种coprocessor跟触发器相像:当特定的时间发生时,回调函数就会执行。

RegionObserver

处理数据操纵事件(data manipulationevents),这种coprocessor是和表的region紧密相连的。可以看作DML Coprocessor

MasterObserver

处理数据管理事件,是cluster范围的coprocessor。可以看做DDL Coprocessor

WALObserver

处理 write-ahead log processing 事件

2.Endpoint

The Coprocessor Class

所有的coprocessor类必须实现org.apache.hadoop.hbase.Coprocessor接口。

1.属性

PRIORITY_HIGHEST,PRIORITY_SYSTEM,PRIORITY_USER,PRIORITY_LOWEST四个静态常量表示coprocessor的优先级.值越低优先级越高。

2.方法

start(env) stop(env) :这两个方法在coprocessor开始及退役的时候被调用(these two methods are called when the coprocessor class is started,and eventually when it is decommissioned)

evn参数用来保存coprocessor整个生命周期的状态。

- package org.apache.hadoop.hbase;

- import java.io.IOException;

- /**

- * Coprocess interface.

- */

- public interface Coprocessor {

- static final int VERSION = 1;

- /** Highest installation priority */

- static final int PRIORITY_HIGHEST = 0;

- /** High (system) installation priority */

- static final int PRIORITY_SYSTEM = Integer.MAX_VALUE / 4;

- /** Default installation priority for user coprocessors */

- static final int PRIORITY_USER = Integer.MAX_VALUE / 2;

- /** Lowest installation priority */

- static final int PRIORITY_LOWEST = Integer.MAX_VALUE;

- /**

- * Lifecycle state of a given coprocessor instance.

- */

- public enum State {

- UNINSTALLED,

- INSTALLED,

- STARTING,

- ACTIVE,

- STOPPING,

- STOPPED

- }

- // Interface

- void start(CoprocessorEnvironment env) throws IOException;

- void stop(CoprocessorEnvironment env) throws IOException;

- }

Coprocessor Loading 加载coprocessor

静态加载和动态加载。

静态加载:在hbase-site.xml中做类似下面的配置

- <property>

- <name>hbase.coprocessor.region.classes</name>

- <value>coprocessor.RegionObserverExample,coprocessor.AnotherCoprocessor</value>

- </property>

- <property>

- <name>hbase.coprocessor.master.classes</name>

- <value>coprocessor.MasterObserverExample</value>

- </property>

- <property>

- <name>hbase.coprocessor.wal.classes</name>

- <value>coprocessor.WALObserverExample,bar.foo.MyWALObserver</value>

- </property>

动态加载:通过table descriptor提供的接口实现;看下面的例子,创建表testtable,动态加载RegionObserverExample到该表的region

- public class LoadWithTableDescriptorExample {

- public static void main(String[] args) throws IOException

- {

- Configuration conf = HBaseConfiguration.create();

- FileSystem fs = FileSystem.get(conf);

- //coprocessor所在的jar包的存放路径

- Path path = new Path(fs.getUri() + Path.SEPARATOR +"test/coprocessor/"+

- "test.jar");

- //HTableDescriptor

- HTableDescriptor htd = new HTableDescriptor("testtable");

- //addFamily

- htd.addFamily(new HColumnDescriptor("colfam1"));

- //

- //设置要加载的corpocessor

- htd.setValue("COPROCESSOR$1", path.toString() +

- "|" + RegionObserverExample.class.getCanonicalName() +

- "|" + Coprocessor.PRIORITY_USER);

- //

- HBaseAdmin admin = new HBaseAdmin(conf);

- //创建表"testtable"

- admin.createTable(htd);

- System.out.println("end");

- }

- }

下面是RegionObserverExample类的实现, 编译通过后,将该类打包成test.jar,并上传到hdfs://master:9000/test/coprocessor目录下

- package coprocessor;

- import java.io.IOException;

- import java.sql.Date;

- import java.util.List;

- import org.apache.commons.net.ntp.TimeStamp;

- import org.apache.hadoop.hbase.KeyValue;

- import org.apache.hadoop.hbase.client.Get;

- import org.apache.hadoop.hbase.coprocessor.BaseRegionObserver;

- import org.apache.hadoop.hbase.coprocessor.ObserverContext;

- import org.apache.hadoop.hbase.coprocessor.RegionCoprocessorEnvironment;

- import org.apache.hadoop.hbase.util.Bytes;

- public class RegionObserverExample extends

- BaseRegionObserver {

- public static final byte[] FIXED_ROW =

- Bytes.toBytes("@@@GETTIME@@@");

- //实现功能:用get查询 "@@@GETTIME@@@"行时,以字节数组形式返回系统时间

- @Override

- public void preGet(

- final ObserverContext<RegionCoprocessorEnvironment> e,

- final Get get, final List<KeyValue> results) throws

- IOException {

- if (Bytes.equals(get.getRow(), FIXED_ROW)) {

- KeyValue kv = new KeyValue(get.getRow(), FIXED_ROW,

- FIXED_ROW,

- Bytes.toBytes(System.currentTimeMillis()));

- results.add(kv);

- }

- }

- public static void main(String args[]){

- System.out.println("complete!");

- }

- }

Endpoints

前面提到的RegionObserver例子通过已知的row key参数,将列计算功能添加到get请求期间。看起来这足以实现其他功能,比如恩能够返回所有给定列的value的和的聚合函数。然而,RegionObserver并不能实现上述功能,因为row key 决定了由哪个region处理request,这样就只能将计算请求(computation request)发送到单一的server上。

HBase为了克服上述RegionObserver的局限性,由coprocessor框架提供了一个动态调用实现(a dynamic call implementation),称作endpoint concept.

The CoprocessorProtocol interface

The BaseEndpointCoprocessor class

实现一个endpoint包括以下两个步骤

1.Extend the CoprocessorProtocol interface

2.Extend the BaseEndpointCoprocessor class

下面是一个小例子,实现功能:客户端通过远程调用检索每个region的行数和KeyValue的个数。

1.RowCountProtocol interface, code:

- public interface RowCountProtocol extends CoprocessorProtocol {

- //获取行数

- long getRowCount() throws IOException;

- //获取应用Filter后的结果集的行数

- long getRowCount(Filter filter) throws IOException;

- //获取KeyValue的个数

- long getKeyValueCount() throws IOException;

- }

2.RowCountEndPoint class, code:

- public class RowCountEndPoint extends BaseEndpointCoprocessor implements

- RowCountProtocol {

- public RowCountEndPoint() {

- // TODO Auto-generated constructor stub

- }

- @Override

- public long getRowCount() throws IOException {

- // TODO Auto-generated method stub

- return this.getRowCount(new FirstKeyOnlyFilter());

- }

- @Override

- public long getRowCount(Filter filter) throws IOException {

- // TODO Auto-generated method stub

- return this.getRowCount(filter,false);

- }

- @Override

- public long getKeyValueCount() throws IOException {

- // TODO Auto-generated method stub

- return this.getRowCount(null,true);

- }

- public long getRowCount(Filter filter,boolean countKeyValue) throws IOException {

- // TODO Auto-generated method stub

- Scan scan =new Scan();

- scan.setMaxVersions(1);

- if(filter !=null){

- scan.setFilter(filter);

- }

- RegionCoprocessorEnvironment environment=

- (RegionCoprocessorEnvironment) this.getEnvironment();

- //使用内部scanner做扫描。

- InternalScanner scanner = environment.getRegion().getScanner(scan);

- //

- long result=0;

- //计数

- try{

- boolean done=false;

- List<KeyValue> curValue = new ArrayList<KeyValue>();

- do{

- curValue.clear();

- done=scanner.next(curValue);

- result+=countKeyValue?curValue.size():1;

- }while(done);

- }catch(Exception e){

- e.printStackTrace();

- }finally{

- scanner.close();

- }

- return result;

- }

- /**

- * @param args

- */

- public static void main(String[] args) {

- // TODO Auto-generated method stub

- System.out.println("success!");

- }

- }

3.

3.1将上述类打包到my_coprocessor.jar, copy到各个RegionServer节点的 $HBASE_HOME/lib目录下;

3.2修改$HBASE_HOME/conf/hbase-site.xml配置文件,添加如下信息:

- <property>

- <name>hbase.coprocessor.region.classes</name>

- <value>

- coprocessor.RegionObserverExample,

- coprocessor.RowCountEndPoint

- </value>

- </property>

3.3 重启HBase Cluster

4.通过客户端调用之前定义的EndPoint Coprocessor

- public class EndPointExample {

- /**

- * @author mango_song

- * @param args

- * @throws IOException

- */

- public static void main(String[] args) throws IOException {

- // TODO Auto-generated method stub

- Configuration conf = HBaseConfiguration.create();

- HTable table =new HTable(conf,"test");

- try {

- //

- /*table.coprocessorExec 函数的描述信息:

- * <RowCountProtocol, Long> Map<byte[], Long> org.apache.hadoop.hbase.client.HTable.coprocessorExec(

- * Class<RowCountProtocol> protocol,

- * byte[] startKey, byte[] endKey,

- * Call<RowCountProtocol, Long> callable)

- * throws IOException, Throwable

- Invoke the passed org.apache.hadoop.hbase.client.coprocessor.Batch.Call

- against the CoprocessorProtocol instances running in the selected regions.

- All regions beginning with the region containing the startKey row,

- through to the region containing the endKey row (inclusive) will be used.

- If startKey or endKey is null, the first and last regions in the table,

- respectively, will be used in the range selection.

- Specified by: coprocessorExec(...) in HTableInterface

- Parameters:

- protocol the CoprocessorProtocol implementation to call

- startKey start region selection with region containing this row

- endKey select regions up to and including the region containing this row

- callable wraps the CoprocessorProtocol implementation method calls made per-region

- Returns:

- a Map of region names to org.apache.hadoop.hbase.client.coprocessor.Batch.Call.call(Object) return values

- Throws:

- IOException

- Throwable

- */

- Map<byte[], Long> results=table.coprocessorExec(

- RowCountProtocol.class,

- null,

- null,

- new Batch.Call<RowCountProtocol, Long>() {

- @Override

- public Long call(RowCountProtocol instance)

- throws IOException {

- // TODO Auto-generated method stub

- return instance.getRowCount();

- }

- }

- );

- long total =0;

- //打印出每个region的行数及总行数

- for(Map.Entry<byte[], Long> entry:results.entrySet() ){

- total += entry.getValue();

- System.out.println("Region: "+Bytes.toString(entry.getKey()) +

- ", Count: "+entry.getValue());

- }

- System.out.println("Total Count: "+total);

- } catch (Throwable e) {

- // TODO Auto-generated catch block

- e.printStackTrace();

- }

- }

- }

运行结果如下,可以看出test表共由三个region组成,每个region拥有的行数分别为9,13,78

- 13/01/26 18:59:53 INFO zookeeper.ClientCnxn: Opening socket connection to server master/172.21.15.21:2181. Will not attempt to authenticate using SASL (无法定位登录配置)

- 13/01/26 18:59:53 INFO zookeeper.ClientCnxn: Socket connection established to master/172.21.15.21:2181, initiating session

- 13/01/26 18:59:53 INFO zookeeper.ClientCnxn: Session establishment complete on server master/172.21.15.21:2181, sessionid = 0x13c6a82639f000c, negotiated timeout = 40000

- Region: test,,1358337586380.f3e04b8b43d073a509e9a374f643277a., Count: 9

- Region: test,209,1358337769870.be5a99319eca6f2881ccd73789bfafb0., Count: 13

- Region: test,222,1358337769870.94685f417a95e91d0c9185a95974f866., Count: 78

- Total Count: 100

Batch类提供了一个更方便的方法来获取远程endpoint, Batch.forMethod() ,你可以得到一个配置好的Batch.Call实例用来传递到远程的region servers. 下面对EndPointExample做了修改,看起来是不是好看多了~~

- Batch.Call call =Batch.forMethod(RowCountEndPoint.class, "getKeyValueCount");

- Map<byte[], Long> results=table.coprocessorExec(

- RowCountProtocol.class,

- null,

- null,

- call

- );

然而,通过直接implementing Batch.Call 更加灵活和强大,(you can perform additional processing on the results ,implementing Batch.call directly will provide more power and flexibility.) 下面的例子,同时获取rowCount和keyvalueCount

- Map<byte[],Pair<Long,Long>> results=table.coprocessorExec(

- RowCountProtocol.class,

- null,

- null,

- new Batch.Call<RowCountProtocol,Pair<Long,Long>>() {

- @Override

- public Pair<Long, Long> call(RowCountProtocol instance)

- throws IOException {

- // TODO Auto-generated method stub

- return new Pair<Long, Long>(

- instance.getRowCount(),

- instance.getKeyValueCount()

- );

- }

- }

- );

- //

- long totalRows=0;

- long totalKeyValues=0;

- for(Map.Entry<byte[], Pair<Long,Long>> entry:results.entrySet() ){

- totalRows+=entry.getValue().getFirst();

- totalKeyValues+=entry.getValue().getSecond();

- System.out.println("region="+Bytes.toString(entry.getKey())+

- " , rowCount="+entry.getValue().getFirst()+

- " , keyValueCount="+entry.getValue().getSecond());

- }

- System.out.println("totalRows="+totalRows+

- ",totalKeyValues="+totalKeyValues);

当然,我们也可以通过coprocessorProxy()方法获取endpoint的client-side 代理,通过该代理,可以在给定的row key所在的region做你想要的操作 (如果row key不存在,则该对应的region为rowkey范围包含该row key的region)。

- RowCountProtocol protocol=table.coprocessorProxy(RowCountProtocol.class, Bytes.toBytes("202"));

- long rowsInRegion = protocol.getRowCount();

- System.out.println("Region Row Count: "+rowsInRegion);

另一种动态加载方法,通过modifytable修改表方式:

- public static void main(String[] args) throws MasterNotRunningException,

- Exception {

- // TODO Auto-generated method stub

- byte[] tableName = Bytes.toBytes("userinfo");

- Configuration conf = HBaseConfiguration.create();

- HBaseAdmin admin = new HBaseAdmin(conf);

- admin.disableTable(tableName);

- HTableDescriptor htd = admin.getTableDescriptor(tableName);

- htd.addCoprocessor(AggregateImplementation.class.getName(), new Path("hdfs://master68:8020/sharelib/aggregate.jar"), 1001, null);

- //htd.removeCoprocessor(RowCountEndpoint.class.getName());

- admin.modifyTable(tableName, htd);

- admin.enableTable(tableName);

- admin.close();

- }

HBase Coprocessor 剖析与编程实践 - 林场 - 博客园

1.起因(Why HBase Coprocessor)

HBase作为列族数据库最经常被人诟病的特性包括:无法轻易建立“二级索引”,难以执行求和、计数、排序等操作。比如,在旧版本的(<0.92)Hbase中,统计数据表的总行数,需要使用Counter方法,执行一次MapReduce Job才能得到。虽然HBase在数据存储层中集成了MapReduce,能够有效用于数据表的分布式计算。然而在很多情况下,做一些简单的相加或者聚合计算的时候,如果直接将计算过程放置在server端,能够减少通讯开销,从而获得很好的性能提升。于是,HBase在0.92之后引入了协处理器(coprocessors),实现一些激动人心的新特性:能够轻易建立二次索引、复杂过滤器(谓词下推)以及访问控制等。

2.灵感来源( Source of Inspration)

HBase协处理器的灵感来自于Jeff Dean 09年的演讲( P66-67)。它根据该演讲实现了类似于bigtable的协处理器,包括以下特性:

- 每个表服务器的任意子表都可以运行代码

- 客户端的高层调用接口(客户端能够直接访问数据表的行地址,多行读写会自动分片成多个并行的RPC调用)

- 提供一个非常灵活的、可用于建立分布式服务的数据模型

- 能够自动化扩展、负载均衡、应用请求路由

3.细节剖析(Implementation)