数据湖存储系统Paimon

Paimon简介

Apache Paimon 是一个面向大数据生态系统的高性能数据湖存储系统。它最初是由 Flink 社区开发的,旨在为大数据处理提供高效的存储解决方案。

Apache Paimon(以前称为 Flink Table Store)是一个专为流处理和批处理而设计的数据湖存储系统。它解决了现代数据处理中的一些关键问题,以下是一些主要的方面:

- 统一的批处理和流处理:传统的数据处理系统通常将批处理和流处理分开,导致架构复杂性增加。Apache Paimon 提供了一种统一的存储格式,支持高效的批处理和流处理,简化了数据管道的构建和维护。

- 高效的数据更新和删除:许多数据湖解决方案在处理更新和删除操作时效率较低。Paimon 通过支持高效的增量更新和删除操作,提升了数据处理的灵活性,适合需要频繁更新的数据场景。

- 事务一致性:在数据湖中实现事务一致性是一个挑战。Paimon 提供了 ACID 事务支持,确保数据操作的原子性、一致性、隔离性和持久性,增强了数据的可靠性和一致性。

- 优化的存储格式:Paimon 使用了优化的存储格式,支持列式存储和高效的数据压缩,这不仅提高了查询性能,还降低了存储成本。

- 与 Apache Flink 的深度集成:Paimon 与 Apache Flink 深度集成,使得在 Flink 上构建实时数据应用变得更加容易。这种集成使得开发者可以利用 Flink 强大的流处理能力,直接在 Paimon 上执行复杂的实时分析任务。

- 元数据管理:Paimon 提供了强大的元数据管理功能,支持对大规模数据集的高效管理和操作,简化了数据治理和合规性管理。

通过解决这些问题,Apache Paimon 为需要处理大规模数据的企业提供了一种高效、灵活且一致的数据存储和处理解决方案。

设计目标

- 实时性:Apache Paimon 旨在支持实时数据处理和分析,使得用户可以对不断变化的数据进行快速查询和处理。

- 高吞吐和低延迟:系统设计考虑了高吞吐量和低延迟的需求,能够处理大规模数据的同时,保持较低的响应时间。

- 事务支持:支持 ACID 事务,以确保数据的一致性和可靠性,即使在高并发环境下也能保证数据的正确性。

- 易于集成:Paimon 可以与多种大数据处理框架无缝集成,如 Apache Flink、Apache Spark 等,提供灵活的数据处理能力。

核心特性

- 数据湖架构:采用数据湖架构,允许用户在存储中保存大规模的结构化和非结构化数据,并对其进行管理和分析。

- Schema 演化:支持动态的 Schema 演化,允许在不影响现有数据和查询的情况下进行 Schema 的更改。

- 高效的存储格式:使用高效的列式存储格式(如 Parquet 或 ORC),以减少存储空间和提高查询性能。

- 数据版本管理:提供数据版本管理功能,支持时间旅行查询(Time Travel Query),用户可以查询历史数据快照。

- 高可用性和扩展性:设计为分布式系统,能够在多节点环境中运行,提供高可用性和良好的扩展性。

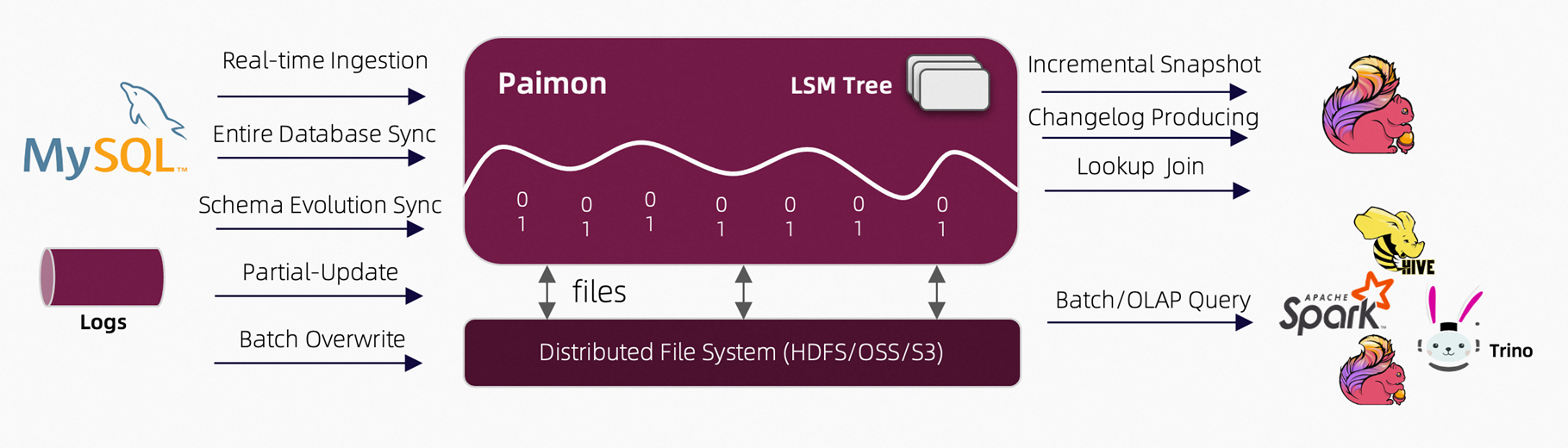

目前Apache Paimon提供以下核心能力:

- 基于HDFS或者对象存储构建低成本的轻量级数据湖存储服务。

- 支持在流模式与批模式下读写大规模数据集。

- 支持分钟级到秒级数据新鲜度的批查询和OLAP查询。

- 支持消费与产生增量数据,可作为传统数仓与流式数仓的各级存储。

- 支持预聚合数据,降低存储成本与下游计算压力。

- 支持历史版本回溯。

- 支持高效的数据过滤。

- 支持表结构变更。

应用场景

- 实时数据分析:适用于需要对流数据进行实时分析的场景,如金融交易分析、实时用户行为分析等。

- 大规模数据处理:适合需要处理和存储大规模数据的企业,提供高效的数据存储和查询能力。

- 数据湖和数据仓库集成:可以作为数据湖的一部分,与传统数据仓库系统集成,为数据分析提供灵活的解决方案。

社区和发展

Apache Paimon 是 Apache 软件基金会下的一个开源项目,受益于活跃的开发者社区和用户群体。其持续的发展和更新,使其不断适应大数据领域的新需求和新挑战。

paimon的生态系统

Apache Paimon 的生态系统设计旨在与现有的大数据处理框架和工具无缝集成,从而提供灵活性和易用性。以下是关于 Paimon 在兼容性和集成方面的一些细节:

兼容性

与 Hadoop 的兼容性:

- 存储兼容性:Paimon 可以部署在 Hadoop 兼容的存储系统上,比如 HDFS。这使得用户可以利用现有的 Hadoop 基础设施来存储和管理数据。

- 生态系统工具支持:Paimon 可以与 Hadoop 生态系统中的其他工具(如 Hive)集成,支持在这些工具中查询和处理 Paimon 存储的数据。

与 Spark 的兼容性:

- 数据源和数据接收器:Paimon 提供了与 Apache Spark 的集成,允许 Spark 任务将数据写入 Paimon 或从 Paimon 读取数据。通过 Spark 的 DataFrame API,用户可以方便地对 Paimon 数据进行复杂的批处理分析。

- 流处理支持:Paimon 的流数据更新能力可以与 Spark Streaming 集成,实现实时数据处理。

与 Flink 的兼容性:

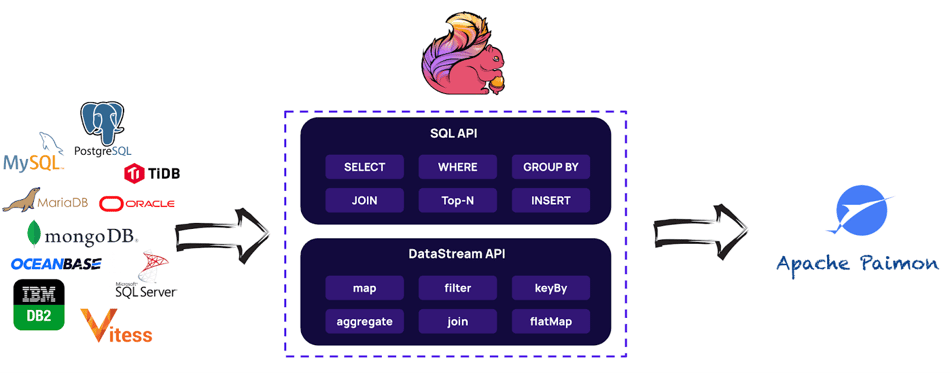

- 深度集成:Paimon 与 Apache Flink 的深度集成是其一大特色。Flink 用户可以使用 Paimon 作为流式和批处理作业的存储层,利用 Flink 强大的流处理能力直接对 Paimon 数据进行操作。

- 统一 API 支持:通过 Flink 的 Table API 和 SQL,用户可以在 Paimon 数据上执行统一的批处理和流处理任务。

集成

与大数据处理框架的集成:

- Paimon 提供了与多种大数据处理框架的连接器和 API,使得这些框架可以轻松地将数据读写到 Paimon。开发者可以通过标准的 API 和连接器将 Paimon 纳入现有的数据处理管道。

与数据湖和数据仓库的集成:

- Paimon 可以作为数据湖的一部分,与其他数据湖技术(如 Delta Lake 或 Apache Iceberg)共同使用,提供统一的存储和管理能力。

- 通过与数据仓库系统的集成,Paimon 可以支持更复杂的分析和查询需求。

可扩展的插件体系:

- Paimon 支持插件机制,允许用户和开发者根据具体需求扩展其功能。这种灵活性使得 Paimon 能够适应多种应用场景和技术栈。

通过与这些大数据生态系统的兼容性和集成能力,Apache Paimon 提供了一种灵活而强大的解决方案,能够在不改变现有基础设施的情况下提升数据处理能力。

Paimon的核心概念

Apache Paimon 是一种专为流处理和批处理设计的数据湖存储系统,其数据存储设计旨在提供高效的数据读写、更新和删除操作。

数据存储格式

列式存储:

- Paimon 采用列式存储格式,类似于 Apache Parquet 或 ORC。这种格式有助于提高查询性能,特别是在需要扫描大量数据但只访问部分列的情况下。

- 列式存储也支持更高效的数据压缩,从而降低存储成本。

分区和分桶:

- 数据可以按特定的字段进行分区和分桶。这种方式有助于提高数据的访问速度,因为查询可以更快地定位到相关的数据分区或分桶。

- 分区和分桶策略可以根据数据访问模式进行配置,以优化性能。

数据更新和删除

增量更新:

- Paimon 支持高效的增量更新,这意味着可以在不重写整个数据集的情况下对数据进行更新。这对于需要频繁更新的数据集(如实时数据)非常重要。

- 通过维护数据的增量变化,Paimon 可以快速地应用更新而不影响整体性能。

删除操作:

- 支持基于条件的删除操作,允许用户删除符合特定条件的数据。

- Paimon 通过维护有效数据的快照来管理删除操作,这样可以在不影响读取性能的情况下安全地删除数据。

事务一致性

ACID 事务:

- Paimon 提供了 ACID 事务支持,确保数据操作的原子性、一致性、隔离性和持久性。

- 事务支持使得用户可以安全地进行并发数据操作,而无需担心数据不一致的问题。

快照机制:

- Paimon 使用快照机制来管理数据版本和事务。这种机制允许用户查看和回滚到特定时间点的数据状态。

- 快照机制也有助于实现数据的时间旅行查询(Time Travel Query),用户可以查询历史数据状态。

元数据管理

元数据存储:

- Paimon 的元数据可以存储在多种后端,包括文件系统和数据库。元数据存储用于管理表结构、分区信息和快照等。

- 高效的元数据管理使得 Paimon 可以在大规模数据集上提供快速的查询和更新。

Schema 演变:

- Paimon 支持 Schema 演变,允许用户在不影响现有数据的情况下修改表结构。这种灵活性对于需要不断调整数据模型的应用非常有用。

数据读写性能

高效的读取:

- Paimon 的列式存储和分区策略使得读取操作非常高效,特别是在只需访问部分列或特定分区时。

- 支持向量化查询处理,进一步提高读取性能。

写入优化:

- 通过批量写入和增量更新机制,Paimon 优化了写入性能,减少了 I/O 开销。

- 支持流式数据写入,使其适合实时数据处理场景。

索引

索引是提高数据查询性能的有效工具。在 Paimon 中,虽然具体的索引机制可能依赖于底层的存储和计算引擎,但一般支持以下几种常见的索引类型:

主键索引:

- 主键索引用于快速定位特定的记录。对于需要频繁进行更新和删除操作的表,主键索引是非常有用的。

- 使用场景:主键索引适用于需要快速检索单条记录的场景,如根据订单 ID 查询订单详情。

二级索引:

- 二级索引用于加速非主键列的查询。它允许在非主键列上进行高效的查找操作。

- 使用场景:在频繁按某个非主键字段进行过滤查询时,二级索引可以显著提高性能。

分区索引:

- 分区本身可以视作一种粗粒度的索引,通过将数据按某个字段分区,可以快速定位到相关的数据块。

- 使用场景:按时间或地理位置等字段进行查询时,分区索引可以减少扫描的数据量。

缓存机制

缓存机制通过在内存中存储数据的部分或全部,提高数据访问速度,减少对磁盘的 I/O 操作。

查询结果缓存:

- 查询结果缓存是指将经常访问的查询结果存储在内存中,以便在重复查询时可以直接返回缓存结果,而无需重新计算。

- 使用场景:适用于经常重复执行相同查询的场景,如报表生成或仪表盘展示。

数据块缓存:

- 数据块缓存涉及将常用的数据块(如列块或行块)缓存到内存中,以加快读取速度。

- 使用场景:对于那些访问频率高的数据集,数据块缓存可以显著减少磁盘 I/O。

元数据缓存:

- 元数据缓存用于存储表结构、分区信息等元数据,以减少查询时的元数据加载时间。

- 使用场景:在大规模数据环境中,元数据缓存可以加快查询计划的生成。

Paimon的使用

Paimon表的创建

创建 Apache Paimon 表通常需要通过 SQL 语句来完成。Paimon 支持标准的 SQL 语法,可以使用各种计算框架(如 Apache Flink 或 Apache Spark)来执行这些 SQL 语句。

使用 Apache Flink 创建 Paimon 表

步骤:

- 设置 Flink 环境:确保 Flink 已正确安装并配置好。确保 Flink 可以访问 Paimon 存储路径。

- 编写 Flink 作业:使用 Flink 的 Table API 或 SQL API 来创建 Paimon 表。

示例代码:

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

public class CreatePaimonTable {

public static void main(String[] args) throws Exception {

// 设置 Flink 执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 创建 Paimon 表

tableEnv.executeSql(

"CREATE TABLE paimon_table (" +

" id INT, " +

" name STRING, " +

" age INT, " +

" PRIMARY KEY (id) NOT ENFORCED" +

") WITH (" +

" 'connector' = 'paimon'," +

" 'path' = 'path/to/paimon/table'" +

")"

);

// 打印表信息

tableEnv.executeSql("DESCRIBE paimon_table").print();

// 执行作业

env.execute("Create Paimon Table");

}

}

使用 Apache Spark 创建 Paimon 表

步骤:

- 设置 Spark 环境:确保 Spark 已正确安装并配置好。确保 Spark 可以访问 Paimon 存储路径。

- 编写 PySpark 脚本:使用 PySpark 的 DataFrame API 或 SQL API 来创建 Paimon 表。

示例代码:

from pyspark.sql import SparkSession

# 创建 SparkSession

spark = SparkSession.builder \

.appName("Create Paimon Table") \

.config("spark.jars.packages", "<paimon-connector-package>") \

.getOrCreate()

# 创建 Paimon 表

spark.sql("""

CREATE TABLE paimon_table (

id INT,

name STRING,

age INT,

PRIMARY KEY (id) NOT ENFORCED

) USING paimon

OPTIONS (

path 'path/to/paimon/table'

)

""")

# 打印表信息

spark.sql("DESCRIBE paimon_table").show()

# 停止 SparkSession

spark.stop()

注意事项

- 路径配置:path参数指定了 Paimon 表在文件系统中的存储路径。确保该路径是可写的,并且 Flink 或 Spark 有权限访问。

- 主键约束:PRIMARY KEY (id) NOT ENFORCED表示定义了一个主键,但不强制执行。Paimon 支持主键约束,但不强制执行可以提高写入性能。

- 连接器包:如果使用 Spark,确保在SparkSession 配置中指定了 Paimon 连接器包(<paimon-connector-package>)。这个包通常是通过 Maven 仓库提供的,需要查找并替换为实际的包名和版本。

- Schema 设计:确保表的 Schema 设计合理,字段类型和名称符合业务需求。

合理的分区

在 Apache Paimon 中,对数据进行分区是一种有效的策略,可以提高查询性能和管理大规模数据集。分区允许将数据划分为更小的部分,使得查询可以更快地定位到相关的数据集,从而减少扫描的数据量。

分区是一种将数据集根据某些字段的值划分为多个逻辑部分的方式。每个分区包含特定字段值范围内的数据。常见的分区字段包括日期、地理位置或其他业务相关字段。

如何设置分区

选择分区字段:

- 选择合适的分区字段是分区策略的关键。通常选择那些在查询条件中经常使用的字段。

- 例如,对于时间序列数据,可以选择时间戳或日期字段进行分区。

定义分区策略:

- 在创建表时定义分区策略。Paimon 支持在表创建时指定分区字段。

- 例如,在 SQL 中创建一个分区表的语法如下:

CREATE TABLE orders (

order_id STRING,

customer_id STRING,

order_date DATE,

amount DOUBLE

) PARTITIONED BY (order_date);

在这个例子中,order_date 字段被用作分区字段。

数据写入和管理:

- 当数据写入 Paimon 时,系统会根据定义的分区策略将数据分配到相应的分区中。

- Paimon 自动管理分区的创建和维护,用户不需要手动管理分区文件或目录。

分区的优点

- 提高查询性能:

- 通过限制查询扫描的分区数量,可以显著提高查询性能。例如,当查询条件包含分区字段时,系统只需扫描相关的分区。

- 这种优化特别适用于大规模数据集。

- 简化数据管理:

- 分区使得数据管理更加简化。用户可以对单个分区执行操作(如删除或归档),而不影响其他分区的数据。

- 这在数据生命周期管理和存储优化方面非常有用。

- 支持增量处理:

- 分区策略还可以帮助实现增量数据处理。例如,可以通过处理新的或特定的分区来实现增量更新或批量操作。

分区的注意事项

- 分区数量:过多的分区可能导致元数据管理开销增加。因此,选择合适的分区粒度非常重要。

- 动态分区:对于某些场景,动态分区(即基于数据内容自动创建分区)可能是有用的,但也需要小心管理以避免过多的分区。

数据导入Paimon

将数据导入到 Apache Paimon 中,通常需要通过与大数据处理框架(如 Apache Flink 或 Apache Spark)的集成来实现。这是因为 Paimon 本身是一个数据湖存储系统,通常需要借助计算框架来进行数据的读写操作。以下是几种常见的方法:

使用 Apache Flink 导入数据

Apache Flink 是与 Paimon 集成最紧密的流处理框架。你可以通过 Flink 作业将数据导入到 Paimon。

步骤:

- 设置 Flink 环境:确保 Flink 已正确安装并配置好。

- 配置 Paimon 表:在 Paimon 中创建一个目标表,定义表的 Schema(字段名称、类型等)。

- 编写 Flink 作业:编写一个 Flink 作业,使用 Paimon 提供的连接器来读取源数据(例如从 Kafka、文件系统、数据库等),并将其写入 Paimon 表。在 Flink 作业中,指定 Paimon 表的路径和配置。

- 运行 Flink 作业:提交并运行 Flink 作业,将数据流式写入 Paimon。

使用 Apache Spark 导入数据

Apache Spark 也是一个常用的数据处理框架,可以用于将批处理数据导入到 Paimon。

步骤:

- 设置 Spark 环境:确保 Spark 已正确安装并配置好。

- 配置 Paimon 表:在 Paimon 中创建一个目标表。

- 编写 Spark 作业:使用 Spark 的 DataFrame API 读取源数据。使用 Paimon 的 Spark 连接器,将 DataFrame 写入到 Paimon 表。

- 运行 Spark 作业:提交并运行 Spark 作业,完成数据导入。

使用命令行工具

如果 Paimon 提供了命令行工具,你也可以直接使用这些工具将数据导入到 Paimon。

步骤:

- 准备数据文件:准备好需要导入的数据文件,通常是 CSV、JSON 等格式。

- 使用命令行工具:使用 Paimon 提供的命令行工具,指定数据文件路径和目标表路径,将数据导入。

使用 API

如果需要更高的灵活性或集成到自定义应用程序中,你可以使用 Paimon 的 Java API 或其他语言支持的 API。

步骤:

- 编写代码:使用 Paimon 提供的 API,编写代码来读取源数据并写入 Paimon 表。

- 运行程序:编译并运行你的程序,将数据导入到 Paimon。

注意事项

- Schema 设计:确保 Paimon 表的 Schema 与源数据的结构匹配。

- 数据格式:确认源数据格式与 Paimon 支持的格式兼容。

- 性能优化:根据数据量和集群配置,适当调整作业的并行度和资源分配,以提高导入性能。

MySQL数据同步paimon示例

要将 MySQL 的 binlog 数据导入到 Apache Paimon 中,你可以使用 Apache Flink 作为数据处理引擎,因为 Flink 提供了对 MySQL binlog 的良好支持。

配置 MySQL binlog

启用 binlog:在 MySQL 配置文件中启用 binlog。

[mysqld] log-bin=mysql-bin server-id=1 binlog-format=ROW

创建用户:为 Flink 创建一个用户,具有读取 binlog 的权限。

CREATE USER 'flink'@'%' IDENTIFIED BY 'password'; GRANT REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'flink'@'%'; FLUSH PRIVILEGES;

编写 Flink 作业

使用 Flink 的 MySQL CDC(Change Data Capture)连接器来读取 MySQL binlog 数据,并将其写入 Paimon。

Flink 作业示例:

依赖配置:确保在 Flink 项目中添加 MySQL CDC 连接器和 Paimon 连接器的依赖。

作业代码:

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.table.api.Table;

import org.apache.flink.connector.mysql.cdc.MySQLSource;

import org.apache.flink.connector.mysql.cdc.config.MySQLSourceConfigFactory;

import org.apache.flink.types.Row;

public class MySQLToPaimon {

public static void main(String[] args) throws Exception {

// 设置 Flink 执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 配置 MySQL Source

MySQLSourceConfigFactory configFactory = MySQLSourceConfigFactory.newBuilder()

.hostname("your-mysql-host")

.port(3306)

.databaseList("your-database")

.tableList("your-database.your-table")

.username("flink")

.password("password")

.build();

MySQLSource<String> mySQLSource = MySQLSource.<String>builder()

.hostname("your-mysql-host")

.port(3306)

.databaseList("your-database")

.tableList("your-database.your-table")

.username("flink")

.password("password")

.deserializer(new StringDebeziumDeserializationSchema())

.build();

// 读取 binlog 数据

DataStream<String> mySQLStream = env.addSource(mySQLSource);

// 将数据转换为表

Table mySQLTable = tableEnv.fromDataStream(mySQLStream);

// 写入 Paimon

tableEnv.executeSql(

"CREATE TABLE paimon_table (...) WITH (...)"

);

mySQLTable.executeInsert("paimon_table");

// 执行作业

env.execute("MySQL Binlog to Paimon");

}

}

运行 Flink 作业

- 编译和打包:将 Flink 作业代码编译并打包成 JAR 文件。

- 提交作业:使用 Flink 提供的命令行工具或 Web UI 将作业提交到 Flink 集群。

验证数据导入

- 检查 Paimon 表:在 Paimon 中检查数据是否正确导入。

- 监控作业:使用 Flink 的监控工具,确保作业正常运行,没有报错。

注意事项

- 数据格式和 Schema:确保 MySQL 表的 Schema 与 Paimon 表的 Schema 一致。

- 错误处理:考虑添加错误处理机制,以便在读取 binlog 或写入 Paimon 过程中出现问题时能及时响应。

- 性能优化:根据数据量和集群配置,调整 Flink 作业的并行度和资源分配,以提高性能。

Paimon数据查询

查询 Apache Paimon 中的数据通常需要借助与之集成的计算框架,如 Apache Flink 或 Apache Spark。这些框架提供了灵活的查询能力,可以对存储在 Paimon 中的数据进行分析和处理。

使用 Apache Flink 查询 Paimon 数据

Flink 提供了流处理和批处理的能力,可以通过 SQL 或 Table API 来查询 Paimon 中的数据。

步骤:

- 设置 Flink 环境:确保 Flink 已正确安装并配置好,并且可以访问 Paimon 存储。

- 编写 Flink SQL 查询:使用 Flink 的 Table API 或 SQL API 来查询 Paimon 中的数据。

示例代码:

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.table.api.Table;

public class PaimonQuery {

public static void main(String[] args) throws Exception {

// 设置 Flink 执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 注册 Paimon 表

tableEnv.executeSql(

"CREATE TABLE paimon_table (" +

" id INT, " +

" name STRING, " +

" age INT" +

") WITH (" +

" 'connector' = 'paimon'," +

" 'path' = 'path/to/paimon/table'" +

")"

);

// 执行查询

Table result = tableEnv.sqlQuery("SELECT * FROM paimon_table WHERE age > 30");

// 输出查询结果

tableEnv.toChangelogStream(result).print();

// 执行作业

env.execute("Paimon Query");

}

}

使用 Apache Spark 查询 Paimon 数据

Spark 也可以通过 DataFrame API 或 SQL 来查询 Paimon 中的数据。

步骤:

- 设置 Spark 环境:确保 Spark 已正确安装并配置好,并且可以访问 Paimon 存储。

- 编写 Spark SQL 查询:使用 Spark 的 DataFrame API 或 SQL API 来查询 Paimon 中的数据。

示例代码:

import org.apache.spark.sql.SparkSession

object PaimonQuery {

def main(args: Array[String]): Unit = {

val spark = SparkSession.builder()

.appName("Paimon Query")

.getOrCreate()

// 读取 Paimon 表

val paimonDF = spark.read

.format("paimon")

.load("path/to/paimon/table")

// 执行查询

val result = paimonDF.filter("age > 30")

// 显示查询结果

result.show()

spark.stop()

}

}

注意事项

- Schema 一致性:确保查询中使用的 Schema 与 Paimon 表的 Schema 一致。

- 性能优化:根据查询的复杂度和数据量,调整 Flink 或 Spark 的资源配置以优化查询性能。

- 集成配置:在使用 Flink 或 Spark 进行查询时,确保正确配置了与 Paimon 的连接器。

PySpark查询Paimon表示例

要使用 PySpark 查询 Apache Paimon 中的数据,你需要确保 Paimon 和 Spark 环境已正确配置,并且可以通过 Spark SQL 或 DataFrame API 来访问和查询 Paimon 中的数据。以下是一个详细的指南,帮助你在 PySpark 中查询 Paimon 数据:

环境准备

- Spark 安装:确保已经安装并配置好 Apache Spark,并且可以使用 PySpark。

- Paimon 连接器:确保 Spark 能够访问 Paimon 的数据存储路径,并配置好必要的连接器(如果需要)。

启动 PySpark Shell 或 编写 PySpark 脚本

你可以选择在 PySpark Shell 中直接运行命令,或者编写一个独立的 PySpark 脚本。

使用 PySpark Shell

pyspark --packages <paimon-connector-package>

编写 PySpark 脚本

from pyspark.sql import SparkSession

# 创建 SparkSession

spark = SparkSession.builder \

.appName("Paimon Query") \

.config("spark.jars.packages", "<paimon-connector-package>") \

.getOrCreate()

# 读取 Paimon 表

paimon_df = spark.read \

.format("paimon") \

.load("path/to/paimon/table")

# 执行查询

result_df = paimon_df.filter(paimon_df.age > 30)

# 显示查询结果

result_df.show()

# 停止 SparkSession

spark.stop()

运行脚本或命令

- 如果使用的是 PySpark Shell,直接在 Shell 中输入相应的命令。

- 如果是独立的 PySpark 脚本,使用 Spark 提供的命令行工具运行脚本:spark-submit –packages <paimon-connector-package> your_script.py

注意事项

- Paimon 连接器:在启动 PySpark Shell 或运行 PySpark 脚本时,需要指定 Paimon 的连接器包。这个包可能是通过 Maven 仓库提供的,你需要查找并替换 <paimon-connector-package> 为实际的包名和版本。

- 数据路径:确保 load(“path/to/paimon/table”) 中的路径正确指向 Paimon 中存储数据的实际路径。

- Schema 一致性:在编写查询时,确保使用的字段名和类型与 Paimon 表的 Schema 保持一致。

- 性能优化:根据数据量和查询复杂度,调整 Spark 的资源配置(如执行器数量和内存)以提高查询性能。

Paimon数据版本管理

Apache Paimon 提供了强大的数据版本管理和时间旅行功能,这些功能对于数据分析和管理非常有用,特别是在需要审计、调试或回溯历史数据时。以下是对 Paimon 数据版本控制和时间旅行功能的详细介绍:

数据版本控制

版本化数据存储:

- Paimon 采用版本化的数据存储机制,每次对数据的更改(如插入、更新或删除)都会生成一个新的版本。

- 这些版本通过快照(Snapshot)进行管理,每个快照代表数据在某一时间点的状态。

快照管理:

- 快照是 Paimon 版本控制的核心。每个快照都有一个唯一的标识符和时间戳,记录了自上一个快照以来的数据变化。

- 快照可以用于回滚数据到某个历史状态,或用于审计和分析。

增量更新:

- 通过维护数据的增量变化,Paimon 可以高效地管理版本。只需存储和处理自上一个版本以来的变化,而不必复制整个数据集。

时间旅行功能

时间旅行查询:

- 时间旅行功能允许用户查询数据在过去某一时间点的状态。通过指定快照 ID 或时间戳,用户可以检索历史数据。

- 这对于需要调试数据问题、执行回溯分析或验证数据变化的场景非常有用。

SQL 支持:

- Paimon 支持通过 SQL 语句执行时间旅行查询。用户可以使用特定的语法指定要查询的快照或时间。

示例查询语法:

SELECT * FROM table_name FOR SYSTEM_TIME AS OF ‘2023-01-01 10:00:00’;

在这个例子中,查询将返回数据在指定时间点的状态。

快照导航:

- 用户可以列出所有可用的快照,并选择特定的快照进行查询。这种导航能力使得用户可以方便地找到需要的历史版本。

实践中的应用

- 数据审计:可以使用时间旅行功能查看数据在某个历史时间点的状态,以满足审计和合规性要求。

- 错误回溯:在发现数据错误时,通过时间旅行功能回溯到错误发生之前的版本,从而帮助定位和修复问题。

- 变化分析:分析数据在不同时间点的变化趋势,以支持业务决策。

管理和优化

- 存储优化:虽然版本控制和时间旅行功能提供了极大的便利,但也会增加存储需求。可以通过配置保留策略,定期清理不再需要的历史版本来优化存储。

- 性能考虑:在执行时间旅行查询时,考虑到数据规模和查询复杂度,以确保查询性能符合要求。

参考链接: